如何利用校验和?本简介向您展示了它们的含义,以及如何利用适当的工具来验证文件的完全性。

当你从互联网高下载软件时,很可能你已经看到了对哈希或校验和的引用。常日,会显示软件,然后在链接附近显示校验和。校验和可以标记为MD5、SHA或其他类似的名称。许多人不知道这些信息到底是什么意思,也不知道如何处理这些信息。在本文中,我将谈论散列的目的以及如何利用它。

1 密码学

密码学的三个目标:

(1)保密性—防止未经授权的用户读取文件内容。

(2)真实性-证明文件的来源。

(3)完全性—证明文件没有意外变动。

目前我们谈论的是第三项,完全性。在这种情形下,完全性意味着证明数据没有意外变动。证明完全性在许多情形下都很有用:Internet下载,如Linux发行版、软件或数据文件。通过NFS、SSH或其他协议进行网络文件传输。验证软件安装。将存储值(如密码)与用户输入的值进行比较,比较两个文件以查看它们是否已变动的备份。

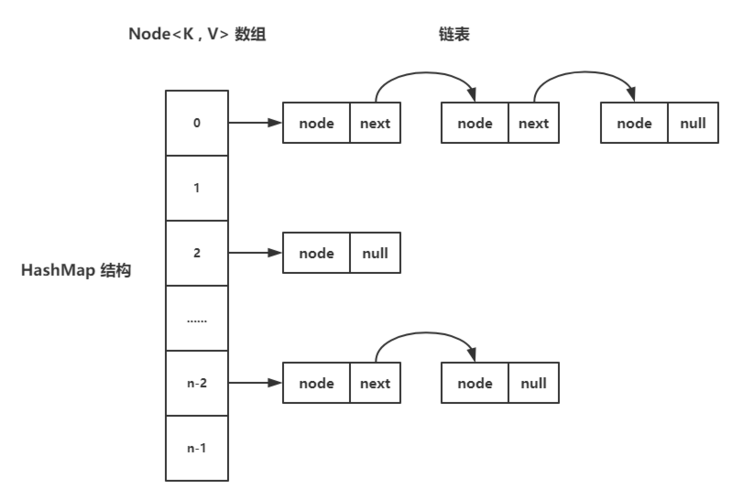

2 什么是哈希?

密码学利用散列来确认文件是不变的。大略的阐明是,在互联网下载的每一端,对一个文件利用相同的哈希方法。web管理员在web做事器上对文件进行哈希处理,并发布哈希结果。用户下载文件并运用相同的哈希方法。比较哈希结果或校验和。如果下载文件的校验和与原始文件的校验和相同,则这两个文件是相同的,并且没有由于文件破坏、中间人攻击等而发生意外变动。

散列是一个单向的过程。哈希结果不能反转以公开原始数据。校验和是设置大小的输出字符串。从技能上讲,这意味着散列不是加密,由于加密是要反转(解密)的。

可以在Linux中利用哪种哈希加密?

3 择要与安全哈希算法

在Linux中,您可能会用到以下两种哈希方法:MD5型,SHA256型。

大多数Linux发行版以及macOS都内置了这些加密工具。Windows常日不包含这些实用程序,因此如果希望利用此安全技能,则必须从第三方供应商处单独下载这些实用程序。我认为像这样的安全工具是Linux和macOS的一部分是很好的。

3.1 择要与安全哈希算法

择要和安全哈希算法有什么差异?不同之处在于所涉及的数学,但两者实现的目标相似,然而,它们不能互换。如果在连接的一端利用SHA256,则在连接的一端利用MD5天生的哈希将不起浸染。两边必须利用相同的哈希方法。

SHA256天生的哈希更大,可能须要更多的韶光和打算能力才能完成。这被认为是一种更安全的方法。MD5对付大多数基本的完全性检讨可能已经足够好了,比如文件下载。

3.2 在Linux中,如何可以找到哈希?

Linux系统中,许多地方都利用了哈希。校验和可以由用户手动天生,在本文后面再详细先容。此外,/etc/shadow、rsync和其他实用程序还包括散列功能。

在/etc/shadow文件中存储的密码实际上是散列。当您登录到Linux系统时,身份验证过程会将存储的哈希值与您键入的密码的哈希版本进行比较。如果两个校验和相同,则原始密码和您键入的密码相同。换句话说,您输入了精确的密码。但是,这是在没有实际解密系统上存储的密码的情形下确定的。检讨/etc/shadow中用户帐户第二个字段的前两个字符。如果这两个字符是$1,那么您的密码将用MD5加密。如果字符是$5,您的密码将用SHA256加密。如果值是$6,则利用SHA512。

例如,利用了SHA512的Fedora虚拟机,可以利用如果命令查看加密类型,如下所示:

sudo tail /etc/shadow | grep -i damon

4. 如何手动天生校验和

利用哈希实用程序非常大略,可以在任何可用的Linux系统上完成。此场景的目的是确定文件是否已变动。首先,创建一个名为original.txt的文件,并在里面写:Original information.。

[damon@localhost ~]$ vim original.txt

[damon@localhost ~]$ cat original.txt

Original information.

接下来,通过哈希算法运行文件。现在用MD5。命令是md5sum。举个例子:

[damon@localhost ~]$ md5sum original.txt

80bffb4ca7cc62662d951326714a71be original.txt

上面得到的校验和值。这个值比较长,很难处理。让我们将该值重定向到一个文件中,以备将来利用:

[damon@localhost ~]$ md5sum original.txt > hashes.txt

[damon@localhost ~]$ cat hashes.txt

80bffb4ca7cc62662d951326714a71be original.txt

将该文件复制到/tmp目录,然后运行md5sum命令以创建复制文件的校验和,末了将结果输出到hashes.txt文件中

[damon@localhost ~]$ cp original.txt /tmp/duplicate.txt

[damon@localhost ~]$ md5sum /tmp/duplicate.txt

80bffb4ca7cc62662d951326714a71be /tmp/duplicate.txt

[damon@localhost ~]$ md5sum /tmp/duplicate.txt >> hashes.txt

比较两次md5结果值这两个散列结果是相同的,因此文件在复制过程中没有变动。

接下来,改变/tmp/duplicate.txt文件内容。

[damon@localhost ~]$ hostname >> /tmp/duplicate.txt

[damon@localhost ~]$ md5sum /tmp/duplicate.txt >> hashes.txt

比较三次md5的结果信息:

[damon@localhost ~]$ cat hashes.txt

80bffb4ca7cc62662d951326714a71be original.txt

80bffb4ca7cc62662d951326714a71be /tmp/duplicate.txt

1f59bbdc4e80240e0159f09ecfe3954d /tmp/duplicate.txt

可以利用--check选项让md5sum为我们进行比较。

[damon@localhost ~]$ md5sum --check hashes.txt

original.txt: OK

/tmp/duplicate.txt: FAILED

/tmp/duplicate.txt: OK

md5sum: WARNING: 1 computed checksum did NOT match

根据上面的步骤,用sha256sum更换md5sum命令,以查看利用SHA算法的进程是如何事情的。sha256sum命令还包含一个--check checksum选项,用于比较结果散列并显示一条,解释文件是否不同。

把稳:如果在Linux、macOS和Windows之间传输文件,仍旧可以利用哈希验证文件的完全性。要在macOS上天生哈希值,请运行md5命令。要在Windows中实行此操作,必须下载第三办法式。我个人利用md5checker。根据Windows上PowerShell的版本,也可以利用PowerShell cmdlet get-filehash。

参考:

[1]https://www.linux.com/news/an-introduction-to-hashing-and-checksums-in-linux/

[2]https://www.redhat.com/sysadmin/hashing-checksums