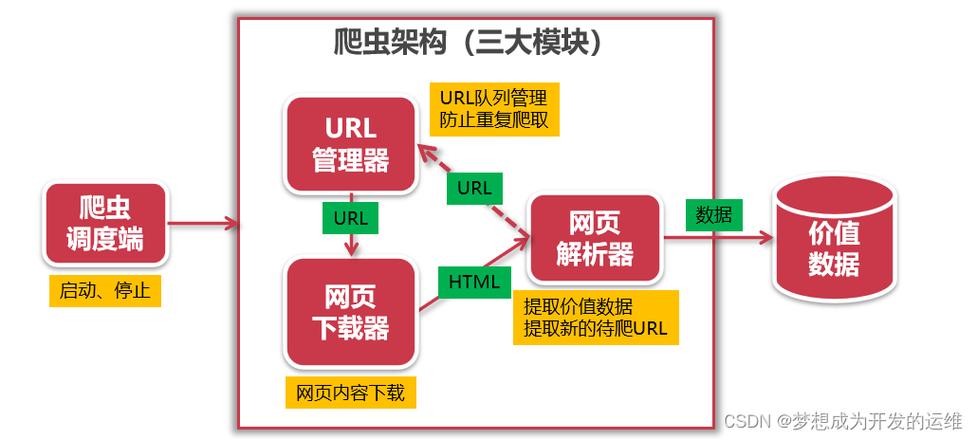

【剖析】

1.创建自定义要求工具的目的,对抗网站的反爬虫机制

2.反爬虫机制1:判断用户是否是浏览器访问(User-Agent)

3.对抗方法1:伪装浏览器进行访问

【把稳】

利用request()来包装要求,再通过urlopen()获取页面。纯挚利用 urlopen 并不能足以构建一个完全的要求,须要给request一个header参数,而header参数便是用来存放User-Agent内容的,发起要求须要通报header参数;

【代码】

注:User-Agent是Http协议中的一部分,属于头域的组成部分,User Agent也简称UA。用较为普通的一点来说,是一种向访问网站供应你所利用的浏览器类型、操作系统及版本、CPU 类型、浏览器渲染引擎、浏览器措辞、浏览器插件等信息的标识。UA字符串在每次浏览器 HTTP 要求时发送到做事器!