redis上风

redis支持五大数据类型

python普通连接redis

Python操作Redis之连接池

redis操作字符串

redis操作hash/字典

redis操作列表

redis凑集set操作

redis其他操作

redis管道(可以理解为事物)

Redis行列步队实现

redis发布订阅

发布订阅模式的浸染

python+Redis实现发布订阅

Django连接redis

办法一

办法二

redis

redis是一个key-value存储系统。和Memcached类似,它支持存储的value类型相对更多,包括string(字符串)、list(链表)、set(凑集)、zset(sorted set --有序凑集)和hash(哈希类型)。这些数据类型都支持push/pop、add/remove及取交集并集和差集及更丰富的操作,而且这些操作都是原子性的。在此根本上,redis支持各种不同办法的排序。与memcached一样,为了担保效率,数据都是缓存在内存中。差异的是redis会周期性的把更新的数据写入磁盘或者把修正操作写入追加的记录文件,并且在此根本上实现了master-slave(主从)同步

redis上风

利用Redis有哪些好处?

(1) 速率快,由于数据存在内存中,类似于HashMap,HashMap的上风便是查找和操作的韶光繁芜度都是O(1)

(2) 支持丰富数据类型,支持string,list,set,sorted set,hash

(3) 支持事务,操作都是原子性,所谓的原子性便是对数据的变动要么全部实行,要么全部不实行

(4) 丰富的特性:可用于缓存,,按key设置过期韶光,过期后将会自动删除

redis比较memcached有哪些上风?

(1) memcached所有的值均是大略的字符串,redis作为其替代者,支持更为丰富的数据类型

(2) redis的速率比memcached快很多

(3) redis可以持久化其数据

redis常识趣能问题和解决方案:

(1) Master最好不要做任何持久化事情,如RDB内存快照和AOF日志文件

(2) 如果数据比较主要,某个Slave开启AOF备份数据,策略设置为每秒同步一次

(3) 为了主从复制的速率和连接的稳定性,Master和Slave最好在同一个局域网内

(4) 只管即便避免在压力很大的主库上增加从库

(5) 主从复制不要用图状构造,用单向链表构造更为稳定,即:Master <- Slave1 <- Slave2 <- Slave3...

这样的构造方便办理单点故障问题,实现Slave对Master的更换。如果Master挂了,可以急速启用Slave1做Master,其他不变。

MySQL里有2000w数据,redis中只存20w的数据,如何担保redis中的数据都是热点数据干系知识:redis 内存数据集大小上升到一定大小的时候,就会施行数据淘汰策略。redis 供应 6种数据淘汰策略:

voltile-lru:从已设置过期韶光的数据集(server.db[i].expires)中挑选最近最少利用的数据淘汰

volatile-ttl:从已设置过期韶光的数据集(server.db[i].expires)中挑选将要过期的数据淘汰

volatile-random:从已设置过期韶光的数据集(server.db[i].expires)中任意选择数据淘汰

allkeys-lru:从数据集(server.db[i].dict)中挑选最近最少利用的数据淘汰

allkeys-random:从数据集(server.db[i].dict)中任意选择数据淘汰

no-enviction(驱逐):禁止驱逐数据

Memcache与Redis的差异都有哪些?

存储办法

Memecache把数据全部存在内存之中,断电后会挂掉,数据不能超过内存大小。

Redis有部份存在硬盘上,这样能担保数据的持久性。

数据支持类型

Memcache对数据类型支持相对大略。

Redis有繁芜的数据类型。

value大小

redis最大可以达到1GB,而memcache只有1MB

Redis 常见的性能问题都有哪些?如何办理?

Master写内存快照,save命令调度rdbSave函数,会壅塞主线程的事情,当快照比较大时对性能影响是非常大的,会间断性停息做事,以是Master最好不要写内存快照。

Master AOF持久化,如果不重写AOF文件,这个持久化办法对性能的影响是最小的,但是AOF文件会不断增大,AOF文件过大会影响Master重启的规复速率。Master最好不要做任何持久化事情,包括内存快照和AOF日志文件,特殊是不要启用内存快照做持久化,如果数据比较关键,某个Slave开启AOF备份数据,策略为每秒同步一次。

Master调用BGREWRITEAOF重写AOF文件,AOF在重写的时候会占大量的CPU和内存资源,导致做事load过高,涌现短暂做事停息征象。

Redis主从复制的性能问题,为了主从复制的速率和连接的稳定性,Slave和Master最好在同一个局域网内

redis 最适宜的场景

Redis最适宜所有数据in-momory的场景,虽然Redis也供应持久化功能,但实际更多的是一个disk-backed的功能,跟传统意义上的持久化有比较大的差别,那么可能大家就会有疑问,彷佛Redis更像一个加强版的Memcached,那么何时利用Memcached,何时利用Redis呢?

如果大略地比较Redis与Memcached的差异,大多数都会得到以下不雅观点:

Redis不仅仅支持大略的k/v类型的数据,同时还供应list,set,zset,hash等数据构造的存储。

Redis支持数据的备份,即master-slave模式的数据备份。

Redis支持数据的持久化,可以将内存中的数据保持在磁盘中,重启的时候可以再次加载进行利用。

会话缓存(Session Cache)

最常用的一种利用Redis的情景是会话缓存(session cache)。用Redis缓存会话比其他存储(如Memcached)的上风在于:Redis供应持久化。当掩护一个不是严格哀求同等性的缓存时,如果用户的购物车信息全部丢失,大部分人都会不高兴的,现在,他们还会这样吗?

幸运的是,随着 Redis 这些年的改进,很随意马虎找到怎么恰当的利用Redis来缓存会话的文档。乃至广为人知的商业平台Magento也供应Redis的插件。

全页缓存(FPC)

除基本的会话token之外,Redis还供应很简便的FPC平台。回到同等性问题,纵然重启了Redis实例,由于有磁盘的持久化,用户也不会看到页面加载速率的低落,这是一个极大改进,类似PHP本地FPC。

再次以Magento为例,Magento供应一个插件来利用Redis作为全页缓存后端。

此外,对WordPress的用户来说,Pantheon有一个非常好的插件 wp-redis,这个插件能帮助你以最快速率加载你曾浏览过的页面。

行列步队

Reids在内存存储引擎领域的一大优点是供应 list 和 set 操作,这使得Redis能作为一个很好的行列步队平台来利用。Redis作为行列步队利用的操作,就类似于本地程序措辞(如Python)对 list 的 push/pop 操作。

如果你快速的在Google中搜索“Redis queues”,你立时就能找到大量的开源项目,这些项目的目的便是利用Redis创建非常好的后端工具,以知足各种行列步队需求。例如,Celery有一个后台便是利用Redis作为broker,你可以从这里去查看。

排行榜/计数器

Redis在内存中对数字进行递增或递减的操作实现的非常好。凑集(Set)和有序凑集(Sorted Set)也使得我们在实行这些操作的时候变的非常大略,Redis只是恰好供应了这两种数据构造。以是,我们要从排序凑集中获取到排名最靠前的10个用户–我们称之为“user_scores”,我们只须要像下面一样实行即可:

当然,这是假定你是根据你用户的分数做递增的排序。如果你想返回用户及用户的分数,你须要这样实行:

发布/订阅

末了(但肯定不是最不主要的)是Redis的发布/订阅功能。发布/订阅的利用场景确实非常多。我已瞥见人们在社交网络连接中利用,还可作为基于发布/订阅的脚本触发器,乃至用Redis的发布/订阅功能来建立谈天系统!

(不,这是真的,你可以去核实)。

Redis供应的所有特性中,我觉得这个是喜好的人最少的一个,虽然它为用户供应如果此多功能。

redis支持五大数据类型

字符串:k1:'123'

列表:[1,2,3,4]

凑集:{1,2,3,4}

字典/哈希表:{name:lqz,age:12}

有序凑集:k5:{('lqz',18),('egon',33)}

reids支持五大数据类型,只支持第一层,也便是说字典的value值必须是字符串,如果value值想存字典格式,那么必须用json转换一下,转成字符串,然后存储;

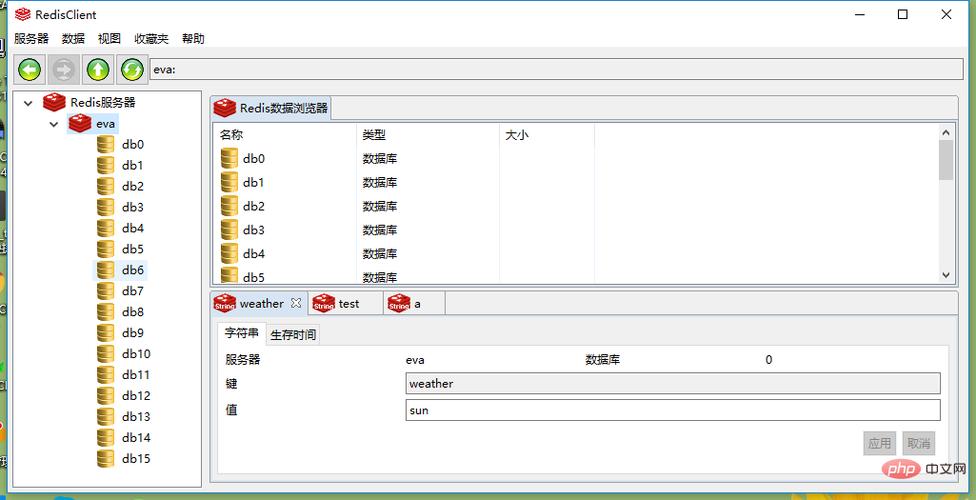

python普通连接redis

redis-py供应两个类Redis和StrictRedis用于实现Redis的命令,StrictRedis用于实现大部分官方的命令,并利用官方的语法和命令,Redis是StrictRedis的子类,用于向后兼容旧版本的redis-py

import redis

r = redis.Redis(host='127.0.0.1', port=6379)

r.set('foo', 'Bar')

print(r.get('foo'))

Python操作Redis之连接池

redis-py利用connection pool来管理对一个redis server的所有连接,避免每次建立、开释连接的开销。默认,每个Redis实例都会掩护一个自己的连接池。可以直接建立一个连接池,然后作为参数Redis,这样就可以实现多个Redis实例共享一个连接池

import redis

# 拿到一个redis的连接池

pool=redis.ConnectionPool(host='127.0.0.1',port=6379,max_connections=100)

# 拿到一个连接

conn=redis.Redis(connection_pool=pool)

# 这样的话每次都会创建池子,以是我们须要借助单例模式来实现连接池,将上面的pool创建为一个模块

redis操作字符串

set(name, value, ex=None, px=None, nx=False, xx=False)

在Redis中设置值,默认,不存在则创建,存在则修正

参数:

ex,过期韶光(秒)

px,过期韶光(毫秒)

nx,如果设置为True,则只有name不存在时,当前set操作才实行,值存在,就修正不了,实行没效果

xx,如果设置为True,则只有name存在时,当前set操作才实行,值存在才能修正,值不存在,不会设置新值

setnx(name, value):设置值,只有name不存在时,实行设置操作(添加),如果存在,不会修正; 实际上便是set(key,value,nx=True)

setex(name, time, value):在设置的时候带上超时时间,实际上便是set(key,value,ex=tinme),单位是秒;

psetex(name, time_ms, value):在设置的时候带上超时时间,实际上便是set(key,value,px=tinme),单位是毫秒;

mset(args, kwargs):批量设置,mset(k1='v1', k2='v2'),mget({'k1': 'v1', 'k2': 'v2'})

get(name):获取值;

mget(keys, args):批量获取值,mget('k1', 'k2'),r.mget(['k3', 'k4']);

getset(name, value):设置新值并获取原来的值;

getrange(key, start, end):取字符,一个汉字三个字符;

setrange(name, offset, value):修正字符串内容,从指定字符串索引开始向后更换(新值太永劫,则向后添加),offset,字符串的索引,字节(一个汉字三个字节),value,要设置的值;

strlen(name):返回name对应值的字节长度(一个汉字3个字节);

incr(self, name, amount=1):自增 name对应的值,当name不存在时,则创建name=amount,否则,则自增,amount,自增数(必须是整数);

decr(self, name, amount=1):自减 name对应的值,当name不存在时,则创建name=amount,否则,则自减,amount,自减数(整数);

append(key, value):在redis name对应的值后面追加内容,value, 要追加的字符串;

redis操作hash/字典

hset(name, key, value):以hash的形式插入数据,name对应的hash中设置一个键值对(不存在,则创建;否则,修正);

参数:

name,redis的name

key,name对应的hash中的key

value,name对应的hash中的value

注:hsetnx(name, key, value),当name对应的hash中不存在当前key时则创建(相称于添加)

hmset(name, mapping):在name对应的hash中批量设置键值对;

参数:

name,redis的name

mapping,字典,如:{'k1':'v1', 'k2': 'v2'}

如:

r.hmset('xx', {'k1':'v1', 'k2': 'v2'})

hget(name,key):在name对应的hash中获取根据key获取value,name是redis数据的name,key是value里面的key;

hmget(name, keys, args):在name对应的hash中获取多个key的值;

参数:

name,reids对应的name

keys,要获取key凑集,如:['k1', 'k2', 'k3']

args,要获取的key,如:k1,k2,k3

如:

r.mget('xx', ['k1', 'k2'])

或

print r.hmget('xx', 'k1', 'k2')

hgetall(name):获取name对应hash的所有键值;

如:

print(re.hgetall('xxx').get(b'name'))

hlen(name):获取name对应的hash中键值对的个数;

hkeys(name):获取name对应的hash中所有的key的值;

hvals(name):获取name对应的hash中所有的value的值;

hexists(name, key):检讨name对应的hash是否存在当前传入的key;

hdel(name,keys):将name对应的hash中指定key的键值对删除;

如:

print(re.hdel('xxx','sex','name'))

hincrby(name, key, amount=1):自增name对应的hash中的指定key的值,不存在则创建key=amount;

参数:

name:redis中的name

key:hash对应的key

amount:自增数(整数);

hincrbyfloat(name, key, amount=1.0):自增name对应的hash中的指定key的值,不存在则创建key=amount;

hscan(name, cursor=0, match=None, count=None):增量式迭代获取,对付数据大的数据非常有用,hscan可以实现分片的获取数据,并非一次性将数据全部获取完,从而放置内存被撑爆;

参数:

name:redis的name;

cursor:游标(基于游标分批取获取数据);

match:匹配指定key,默认None 表示所有的key;

count:每次分片最少获取个数,默认None表示采取Redis的默认分片个数;

如:

第一次:cursor1, data1 = r.hscan('xx', cursor=0, match=None, count=None)

第二次:cursor2, data1 = r.hscan('xx', cursor=cursor1, match=None, count=None)

直到返回值cursor的值为0时,表示数据已经通过分片获取完毕

hscan_iter(name, match=None, count=None):利用yield封装hscan创建天生器,实现分批去redis中获取数据;

参数:

match:匹配指定key,默认None 表示所有的key;

count:每次分片最少获取个数,默认None表示采取Redis的默认分片个数;

如:

for item in r.hscan_iter('xx'):

print item

redis操作列表

List操作,redis中的List在在内存中按照一个name对应一个List来存储;

lpush(name,values):在name对应的list中添加元素,每个新的元素都添加到列表的最左边;

如:

r.lpush('oo', 11,22,33)

保存顺序为: 33,22,11

扩展:

rpush(name, values) 表示从右向左操作

lpushx(name,value):在name对应的list中添加元素,只有name已经存在时,值添加到列表的最左边;

如:

rpushx(name, value) 表示从右向左操作

llen(name):name对应的list元素的个数;

linsert(name, where, refvalue, value)):在name对应的列表的某一个值前或后插入一个新值;

参数:

name,redis的name

where,BEFORE或AFTER(小写也可以)

refvalue,标杆值,即:在它前后插入数据(如果存在多个标杆值,以找到的第一个为准)

value,要插入的数据

r.lset(name, index, value):对name对应的list中的某一个索引位置重新赋值;

参数:

name,redis的name

index,list的索引位置

value,要设置的值

r.lrem(name, value, num):在name对应的list中删除指定的值;

参数:

name,redis的name

value,要删除的值

num, num=0,删除列表中所有的指定值;

num=2,从前到后,删除2个;

num=-2,从后向前,删除2个

lpop(name):在name对应的列表的左侧获取第一个元素并在列表中移除,返回值则是第一个元素;

如:

rpop(name) 表示从右向左操作;

lindex(name, index):在name对应的列表中根据索引获取列表元素;

lrange(name, start, end):在name对应的列表分片获取数据;

参数:

name,redis的name

start,索引的起始位置

end,索引结束位置 print(re.lrange('aa',0,re.llen('aa')))

ltrim(name, start, end):在name对应的列表中移除没有在start-end索引之间的值;

参数:

name,redis的name

start,索引的起始位置

end,索引结束位置(大于列表长度,则代表不移除任何)

rpoplpush(src, dst):从一个列表取出最右边的元素,同时将其添加至另一个列表的最左边;

参数:

src,要取数据的列表的name

dst,要添加数据的列表的name

blpop(keys, timeout):将多个列表排列,按照从左到右去pop对应列表的元素;

参数:

keys,redis的name的凑集

timeout,超时时间,当元素所有列表的元素获取完之后,壅塞等待列表内有数据的韶光(秒), 0 表示永久壅塞

更多:

r.brpop(keys, timeout),从右向左获取数据爬虫实现大略分布式:多个url放到列表里,往里一直放URL,程序循环取值,但是只能一台机器运行取值,可以把url放到redis中,多台机器从redis中取值,爬取数据,实现大略分布式

brpoplpush(src, dst, timeout=0):从一个列表的右侧移除一个元素并将其添加到另一个列表的左侧;

参数:

src,取出并要移除元素的列表对应的name

dst,要插入元素的列表对应的name

timeout,当src对应的列表中没有数据时,壅塞等待其有数据的超时时间(秒),0 表示永久壅塞

# 自定义增量迭代

# 由于redis类库中没有供应对列表元素的增量迭代,如果想要循环name对应的列表的所有元素,那么就须要:

# 1、获取name对应的所有列表

# 2、循环列表

# 但是,如果列表非常大,那么就有可能在第一步时就将程序的内容撑爆,所有有必要自定义一个增量迭代的功能:

import redis

conn=redis.Redis(host='127.0.0.1',port=6379)

# conn.lpush('test',[1,2,3,4,45,5,6,7,7,8,43,5,6,768,89,9,65,4,23,54,6757,8,68])

# conn.flushall()

def scan_list(name,count=2):

index=0

while True:

data_list=conn.lrange(name,index,count+index-1)

if not data_list:

return

index+=count

for item in data_list:

yield item

print(conn.lrange('test',0,100))

for item in scan_list('test',5):

print('---')

print(item)

redis凑集set操作

Set操作,Set凑集便是不许可重复的列表;

有序凑集,在凑集的根本上,为每元素排序;元素的排序须要根据其余一个值来进行比较,以是,对付有序凑集,每一个元素有两个值,即:值和分数,分数专门用来做排序;

sadd(name,values):name对应的凑集中添加元素;

scard(name):获取name对应的凑集中元素个数;

sdiff(keys, args):在第一个name对应的凑集中且不在其他name对应的凑集的元素凑集;

sdiffstore(dest, keys, args):获取第一个name对应的凑集中且不在其他name对应的凑集,再将其新加入到dest对应的凑集中;

sinter(keys, args):获取多一个name对应凑集的并集;

sinterstore(dest, keys, args):获取多一个name对应凑集的并集,再讲其加入到dest对应的凑集中;

sismember(name, value):检讨value是否是name对应的凑集的成员;

smembers(name):获取name对应的凑集的所有成员;

smove(src, dst, value):将某个成员从一个凑集中移动到其余一个凑集;

spop(name):从凑集的右侧(尾部)移除一个成员,并将其返回;

srandmember(name, numbers):从name对应的凑集中随机获取 numbers 个元素;

srem(name, values):在name对应的凑集中删除某些值;

srem(name, values):在name对应的凑集中删除某些值;

sunion(keys, args):获取多一个name对应的凑集的并集;

sunionstore(dest,keys, args):获取多一个name对应的凑集的并集,并将结果保存到dest对应的凑集中;

sscan(name, cursor=0, match=None, count=None)/sscan_iter(name, match=None, count=None):同字符串的操作,用于增量迭代分批获取元素,避免内存花费太大;

zadd(name, args, kwargs):在name对应的有序凑集中添加元素;

如:

zadd('zz', 'n1', 1, 'n2', 2)

zadd('zz', n1=11, n2=22)

zcard(name):获取name对应的有序凑集元素的数量;

zcount(name, min, max):获取name对应的有序凑集等分数 在 [min,max] 之间的个数;

zincrby(name, value, amount):自增name对应的有序凑集的 name 对应的分数;

r.zrange( name, start, end, desc=False, withscores=False, score_cast_func=float):按照索引范围获取name对应的有序凑集的元素;

参数:

name,redis的name

start,有序凑集索引起始位置(非分数)

end,有序凑集索引结束位置(非分数)

desc,排序规则,默认按照分数从小到大排序

withscores,是否获取元素的分数,默认只获取元素的值

score_cast_func,对分数进行数据转换的函数

更多:

从大到小排序

zrevrange(name, start, end, withscores=False, score_cast_func=float)

按照分数范围获取name对应的有序凑集的元素

zrangebyscore(name, min, max, start=None, num=None, withscores=False, score_cast_func=float)

从大到小排序

zrevrangebyscore(name, max, min, start=None, num=None, withscores=False, score_cast_func=float)

zrank(name, value):获取某个值在 name对应的有序凑集中的排行(从 0 开始);

更多:

zrevrank(name, value),从大到小排序

zrangebylex(name, min, max, start=None, num=None):当有序凑集的所有成员都具有相同的分值时,有序凑集的元素会根据成员的 值 (lexicographical ordering)来进行排序,而这个命令则可以返回给定的有序凑集键 key 中, 元素的值介于 min 和 max 之间的成员.对凑集中的每个成员进行逐个字节的比拟(byte-by-byte compare), 并按照从低到高的顺序, 返回排序后的凑集成员。 如果两个字符串有一部分内容是相同的话, 那么命令会认为较长的字符串比较短的字符串要大

参数:

name,redis的name

min,左区间(值)。 + 表示正无限; - 表示负无限; ( 表示开区间; [ 则表示闭区间

min,右区间(值)

start,对结果进行分片处理,索引位置

num,对结果进行分片处理,索引后面的num个元素

如:

ZADD myzset 0 aa 0 ba 0 ca 0 da 0 ea 0 fa 0 ga

r.zrangebylex('myzset', "-", "[ca") 结果为:['aa', 'ba', 'ca']

更多:

从大到小排序

zrevrangebylex(name, max, min, start=None, num=None)

zrem(name, values):删除name对应的有序凑集中值是values的成员;

如:

zrem('zz', ['s1', 's2'])

zremrangebyrank(name, min, max):根据排行范围删除;

zremrangebyscore(name, min, max):根据分数范围删除;

zremrangebylex(name, min, max):根据值返回删除;

zscore(name, value):获取name对应有序凑集中 value 对应的分数;

zinterstore(dest, keys, aggregate=None):获取两个有序凑集的交集,如果碰着相同值不同分数,则按照aggregate进行操作,aggregate的值为: SUM MIN MAX;

zunionstore(dest, keys, aggregate=None):获取两个有序凑集的并集,如果碰着相同值不同分数,则按照aggregate进行操作,aggregate的值为: SUM MIN MAX;

zscan(name, cursor=0, match=None, count=None, score_cast_func=float),zscan_iter(name, match=None, count=None,score_cast_func=float):同字符串相似,相较于字符串新增score_cast_func,用来对分数进行操作;

redis其他操作

delete(names): 根据删除redis中的任意数据类型;

exists(name):检测redis的name是否存在;

keys(pattern=''):根据模型获取redis的name;

如:

KEYS 匹配数据库中所有 key 。

KEYS h?llo 匹配 hello , hallo 和 hxllo 等。

KEYS hllo 匹配 hllo 和 heeeeello 等。

KEYS h[ae]llo 匹配 hello 和 hallo ,但不匹配 hillo

expire(name ,time):为某个redis的某个name设置超时时间;

rename(src, dst):对redis的name重命名为;

move(name, db)):将redis的某个值移动到指定的db下;

randomkey():随机获取一个redis的name(不删除);

type(name):获取name对应值的类型;

scan(cursor=0, match=None, count=None),scan_iter(match=None, count=None):同字符串操作,用于增量迭代获取key;

redis管道(可以理解为事物)

单机的情形下可以用管道来实现事物,集群的情形下管道无法实现事物;

redis-py默认在实行每次要求都会创建(连接池申请连接)和断开(归还连接池)一次连接操作,如果想要在一次要求中指定多个命令,则可以利用pipline实现一次要求指定多个命令,并且默认情形下一次pipline 是原子性操作。

import redis

pool = redis.ConnectionPool(host='10.211.55.4', port=6379)

r = redis.Redis(connection_pool=pool)

# pipe = r.pipeline(transaction=False)

pipe = r.pipeline(transaction=True)

pipe.multi()

pipe.set('name', 'alex')

pipe.set('role', 'sb')

pipe.execute()

Redis行列步队实现

Redis的列表类型键可以用来实现行列步队,并且支持壅塞式读取,可以很随意马虎的实现一个高性能的优先行列步队。同时在更高层面上,Redis还支持"发布/订阅"的模式,可以基于此构建一个谈天系统,redis的列表类型天生支持用作行列步队。(类似于MQ的行列步队模型--任何时候都可以消费,一条只能消费一次)

# queueServer

import redis,time

conn= redis.Redis(host='127.0.0.1', port=6379)

count=0

while True:

time.sleep(3)

conn.lpush('name','name'+str(count))

count+=1

# queueClient

import redis

conn= redis.Redis(host='127.0.0.1', port=6379)

def consume():

while True:

value=conn.brpop('name')

yield value

for v in consume():

print(v)

redis发布订阅

发布订阅模式又叫不雅观察者模式,它定义工具间的一种一对多的依赖关系,当一个工具的状态发生改变时,所有依赖它的工具都将得到关照,Redis 发布订阅(pub/sub)是一种通信模式:发送者(pub)发送,订阅者(sub)吸收。

Redis 客户端可以订阅任意数量的频道。

下图展示了频道 channel1 , 以及订阅这个频道的三个客户端 —— client2 、 client5 和 client1 之间的关系

当有新通过 PUBLISH 命令发送给频道 channel1 时, 这个就会被发送给订阅它的三个客户端

发布订阅模式的浸染

1、用于异步编程,取代通报回调函数的方案;

2、让两个工具松耦合地联系在一起,一个工具不再显式地调用另一个工具的接口;

3、构建实时系统,比如普通的即时谈天,群聊等功能;

4、在我们的分布式架构中,常常会碰着读写分离的场景,在写入的过程中,就可以利用redis发布订阅,使得写入值及时发布到各个读的程序中,就担保数据的完全同等性;

5、在一个博客网站中,有100个粉丝订阅了你,当你发布新文章,就可以推送给粉丝们;

python+Redis实现发布订阅

# 发布者

import redis

conn=redis.Redis(host='127.0.0.1',port=6379)

# 频道,发布内容

conn.publish('98k','hello world')

# 订阅者

import redis

conn=redis.Redis(host='127.0.0.1',port=6379)

# 拿到发布者工具

pub=conn.pubsub()

# 订阅频道

pub.subscribe('98k')

# 可以订阅多个频道

# pub.subscribe('998')

# 循环等待

while True:

# 吸收到,解析相应

msg=pub.parse_response()

print(msg)

Django连接redis

办法一

utils文件夹下,建立redis_pool.py,利用单利工具的办法来做一个redis连接池;

# redis_pool.py

import redis

POOL = redis.ConnectionPool(host='127.0.0.1', port=6379,password='1234',max_connections=1000)

# views.py

import redis

from django.shortcuts import render,HttpResponse

from utils.redis_pool import POOL

def index(request):

conn = redis.Redis(connection_pool=POOL)

conn.hset('kkk','age',18)

return HttpResponse('设置成功')

def order(request):

conn = redis.Redis(connection_pool=POOL)

conn.hget('kkk','age')

return HttpResponse('获取成功')

办法二

安装django-redis模块

# settings.py

# redis配置

CACHES = {

"default": {

"BACKEND": "django_redis.cache.RedisCache",

"LOCATION": "redis://127.0.0.1:6379",

"OPTIONS": {

"CLIENT_CLASS": "django_redis.client.DefaultClient",

"CONNECTION_POOL_KWARGS": {"max_connections": 100}

# "PASSWORD": "123",

}

}

}

# views.py

from django_redis import get_redis_connection

conn = get_redis_connection('default')

print(conn.hgetall('xxx'))