作为入门测试环境搭建,我们先考试测验hadoop单机版支配。

安装JDKJDK下载地址:官方下载地址

scp jdk-8u211-linux-x64.tar.gz devops@192.168.1.106:/home/devops/解压jdk压缩包,移动到安排目录即可

tar zxvf jdk-8u211-linux-x64.tar.gzsudo cp -r jdk1.8.0_211 /usr/local/jdk设置环境变量

sudo vim /etc/profileexport JAVA_HOME=/usr/local/jdkexport JRE_HOME=${JAVA_HOME}/jreexport CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/libexport PATH=${JAVA_HOME}/bin:$PATH测试 java -version

gitlib@devops:~$ java -versionjava version \"大众1.8.0_211\"大众Java(TM) SE Runtime Environment (build 1.8.0_211-b12)Java HotSpot(TM) 64-Bit Server VM (build 25.211-b12, mixed mode)创建Hadoop账号

避免采取root账号操作hadoop,引起安全问题。

输入命令:

sudo useradd -r hadoopsudo usermod -G hadoop hadoop

查看hadoop账户:

gitlib@devops:~$ id hadoopuid=993(hadoop) gid=993(hadoop) groups=993(hadoop)

可以看到hadoop账号已经创建,并且加到hadoop组。

创建hadoop文件目录一共创建4个文件目录:

hadoop临时文件目录mkdir -p /home/hadoop/tmphadoop主节点(namenode)文件目录

mkdir -p /home/hadoop/hdfs/namehadoop数据节点(datanode)文件目录

mkdir -p /home/hadoop/hdfs/datahadoop日志文件目录

mkdir -p /home/hadoop/log设置hadoop文件目录所有者

sudo chown -R hadoop /home/hadoop下载hadoop

hadoop下载地址:官方下载地址

最新版为3.1.2版:

wget https://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-3.1.2/hadoop-3.1.2.tar.gz

下载完成之后,解压安装包即可利用

tar zxvf hadoop-3.1.2.tar.gzsudo cp -ra hadoop-3.1.2 /usr/local/hadoop

将安装目录所有者修正为hadoop:

sudo chown -R hadoop /usr/local/hadoop配置hadoop

hadoop的配置文件都在 etc/hadoop 目录下。

配置文件有很多,最基本要修正3个文件:hadoop-env.sh ,core-site.xml,hdfs-site.xml。

hadoop-env.sh:

修正JAVA_HOME环境变量为JDK的安装路径。

# Technically, the only required environment variable is JAVA_HOME.export JAVA_HOME=/usr/local/jdk/

core-site.xml:

<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9001</value> </property> <property><name>hadoop.tmp.dir</name><value>file:/home/hadoop/tmp</value> </property></configuration>

设置hdfs的监听端口(一样平常配置为9000,我改为了9001,由于和php-fpm的默认端口冲突)和hadoop临时文件目录。

hdfs-site.xml:

<configuration> <property><name>dfs.namenode.name.dir</name><value>file:/home/hadoop/hdfs/name</value> </property> <property><name>dfs.datanode.data.dir</name><value>file:/home/hadoop/hdfs/data</value> </property> <property> <name>dfs.replication</name> <value>1</value> </property></configuration>

设置hdfs的namenode、datanode数据存放路径以及数据块复制备份数量,默认是3,但是由于我们是单机支配,修正为1。

设置SSH免密访问本地须要用前面创建的hadoop用户通过ssh免密访问本地,先切换到hadoop用户目录下,实行以下命令:

zhoufei@devops:~$ su hadoophadoop@devops:~$ cd ~hadoop@devops:~$ cd .ssh/# 天生密钥,全部回车,采取默认值hadoop@devops:~/.ssh$ ssh-keygen -t rsa# 将公钥拷贝到authorized_keys中hadoop@devops:~/.ssh$ cat id_dsa.pub > authorized_keys初始化

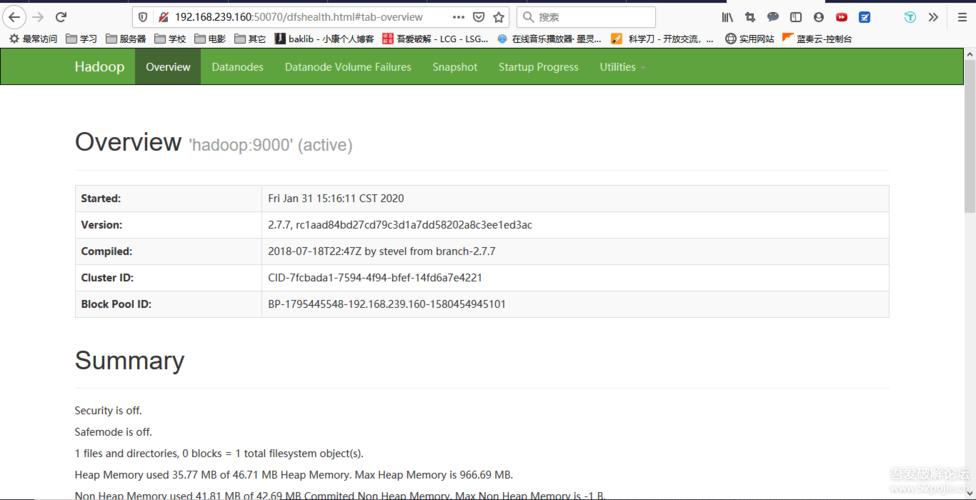

bin/hdfs namenode -format启动hadoop

hadoop供应了一键启动所有组件的脚本,输入命令:

/usr/local/hadoop/sbin/start-all.sh

输入jps:

hadoop@devops:~$ jps17761 NameNode17889 DataNode18083 SecondaryNameNode18532 NodeManager22474 Jps18399 ResourceManager

可以看到namenode、secondarynamenode、datanode、nodemanager、resourcemanager这三个做事已经启动。

输入命令 bin/hadoop fs -ls /,没有报错,则hadoop单机版安装成功。