因此,我们须要理解基本的HDFS配置和命令才能正常利用它。在利用之前,我们首先谈论如何配置安装HDFS。

Hadoop以及HDFS都运行在java环境中,因此我们都须要安装JDK:

设置namenode节点到datanode节点的免密上岸

1、本地免密登录

2、跨主机免密上岸

3、对所有datanode实行上述操作

设置域名解析(在所有节点增加)

由于Hadoop有bin包,以是下载后只需解压即可利用。如果我们利用的是版本hadoop-1.2.1,那就将软件解压到/root/hadoop-1.2.1文件夹中。

把稳:namenode和datanode软件包的放置位置要完备相同,否则在集群启动做事时会涌现找不到文件的情形。

配置

HDFS本地Golang客户端实践

基于上述根本配置,我们也可以考试测验配置HDFS确当地golang客户端,它利用协议缓冲区API直接连接namenode,利用stdlib os包并实现相应接口,包括os.FileInfo和os.PathError。

这是它在action中的状态:

HDFS二进制文件

与库类似,此repo包含HDFS命令行客户端,紧张目标是启用unix动词实现:

由于它不必等待JVM启动,以是hadoop -fs要快得多:

安装命令行客户端

从发布页面抓取tarball并将其解压缩到任意位置。

要配置客户端,请确保个中一个或两个环境变量指向Hadoop配置(core-site.xml和hdfs-site.xml)。在安装了Hadoop的系统上,该当已经设置过上述变量。

要在linux上完成选项卡安装,请将tarball附带的bash_completion文件复制或链接到精确位置:

默认情形下,在非kerberized集群上,HDFS用户可设置为当前登任命户,也可以利用另一个环境变量覆盖它:

利用带有Kerberos身份验证的命令行客户端

与hadoop fs一样,命令行客户端须要在默认位置利用ccache文件:/ tmp / krb5cc_ <uid>。 这意味着它必须“正常事情”才能利用kinit:

如果不起浸染,请考试测验将KRB5CCNAME环境变量设置为保存ccache的位置。

兼容性

该库利用HDFS协议的“Version 9”,这意味着它该当利用基于2.2.x及更高版本的Hadoop发行版,测试针对CDH 5.x和HDP 2.x运行。

检讨机器是否能与HDFS通信

如果想检讨一台机器是否可以与另一台机器上运行的HDFS做事器通信,并从Hadoop wiki中修正一些代码,如下所示:

我最初以为POM文件中只有以下内容:

但运行脚本时,我得到了以下结果:

通过跟踪堆栈跟踪,我意识到犯了一个缺点,即对hadoop-hdfs 2.4.1进行了依赖。如果没有hadoop-hdfs依赖,我们会看到如下缺点:

现在,让我们添加精确的依赖项版本,并确保可以按照预期事情:

运行时,它会在另一台机器上用当前韶光戳在HDFS中创建一个新文件:

(该项目开源地址:https://github.com/colinmarc/hdfs)

根本HDFS命令

完成安装配置后,我们须要理解HDFS根本命令,须要知道每个命令的详细语法。一样平常语法如下:

这将在Hadoop(HDFS)支持的文件系统上运行filesystem命令,别的Command选项如下所示:

1、put命令

'put'命令将数据输入HDFS。

语法:hadoop dfs -put </ source path> </ destination path>

2、List命令

'list'命令显示特定路径中的所有可用文件。

语法:hadoop dfs -ls </ source path>

3、Get命令

'get'命令将上述文件的全部内容复制到本地驱动器。

语法:hadoop dfs -get </ source path> </ destination path>

4、Make Directory命令

'mkdir'命令在指定位置创建一个新目录。

语法:hadoop dfs -mkdir </ source path>

5、查看特定文件的内容

'cat'命令用于显示文件的所有内容。

语法:hadoop dfs -cat </ path [filename]>

6、复制HDFS内的完全文件

'copyfromlocal'命令将文件从本地文件系统复制到HDFS。

语法:hadoop dfs -copyFromLocal </ source path> </ destination path>

7、将文件从HDFS复制到本地文件系统

'copytolocal'命令将文件从HDFS复制到本地文件系统。

语法:hadoop dfs -copyToLocal </ source path> </ destination path>

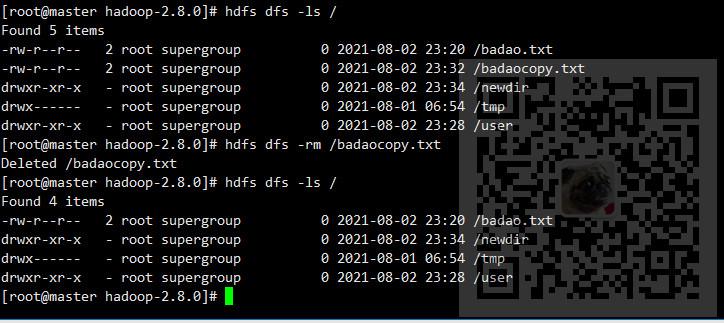

8、删除文件

命令'rm'将删除存储在HDFS中的文件。

语法:hadoop dfs -rm </ path [filename]>

9、运行DFS文件系统以检讨实用程序

命令'fsck'用于检讨文件系统的同等性

语法:hadoop fsck </ file path>

10、集群负载均衡程序

'balancer'命令将检讨集群中节点的事情负载并进行平衡。

语法:hadoop balancer

11、检讨HDFS中的目录空间

该命令将显示集群内文件占用的大小。

语法:hadoop dfs -du -s -h </ file path>

12、列出所有Hadoop文件系统Shell命令

'fs'命令列出了Hadoop文件系统的所有shell命令。

语法:hadoop fs [options]

在Hadoop和HDFS的实际配置中,我们可能会碰着很多问题,好在其弘大的社区支持让我们可以很轻松得找到各种办理方案,如果你对HDFS的观点并不熟习,你也可以考虑阅读本系列的上一篇文章:《扫盲:Hadoop分布式文件系统(HDFS)根本观点讲解!

》