作甚API?如果你在百度百科上搜索,你会得到如下结果:

API(Application Programming Interface,运用程序编程接口)是一些预先定义的函数,目的是供应运用程序与开拓职员基于某软件或硬件得以访问一组例程的能力,而又无需访问源码,或理解内部事情机制的细节。

那么普通一点来说,API是什么呢?从技能角度来说,API指的是运用程序编程接口。很多大型企业都会为自己的客户建立运用程序编程接口,或供内部利用。

本日i春秋针对爬虫FOFA里面的数据进行统计剖析,即API的大略利用,希望对大家有所帮助,本文阅读用时约5分钟。

环境

描述环境为文章中所用到的所有技能以及中间件并非全部安装,可根据利用的规模进行调度利用。

措辞:python2.7(必须)

模块:requests(必须)

操作系统:MacOS 10.13.4(非必须)

分布式行列步队管理:Celery(末了一节安装)

日志记录:logging(必须)

中间价:Redis(末了一节安装)/MySQL(必须)

数据库操作:pymysql(必须)/DBUtils(必须)

安装环境

# 安装requestspip isntall requests# 安装celery Macpip install celery# 安装celery Windowspip isntall celery=3.1.25# 安装 pymysqlpip install pymysql# 安装loggingpip install logging# 安装 DBUtils 数据库连接池pip install DBUtils

注:Windows安装Celery时最好安装3.1.25版本,不然可能会故意想不到的惊喜。

FOFA API

文档:https://fofa.so/api

要求:https://fofa.so/api/v1/search/all

要求办法:GET

要求参数:

相应:

数据库设计

设计数据库存放FOFA爬虫数据,方便统计查询。

SQL语句

DROP TABLE IF EXISTS `fofa_spider`;CREATE TABLE `fofa_spider` ( `id` INT (11) NOT NULL AUTO_INCREMENT, `host` VARCHAR (255) NOT NULL, `ip` VARCHAR (255) NOT NULL, `port` VARCHAR (255) DEFAULT NULL, `protocol` VARCHAR (255) NOT NULL, `country_name` VARCHAR (255) DEFAULT NULL, `region_name` VARCHAR (255) DEFAULT NULL, `city_name` VARCHAR (255) DEFAULT NULL, `fofa_sql` text NOT NULL, `create_date` DATETIME NOT NULL, `update_date` DATETIME NOT NULL, PRIMARY KEY (`id`)) ENGINE = INNODB DEFAULT CHARSET = utf8mb4;

数据库SQL文件:https://github.com/0nise/scripts/blob/master/fofa_spider.sql

小试牛刀

本节紧张讲解可适用与一样平常的FOFA爬虫,如果须要大批量数据爬虫请您接着往下看。

环境

措辞:python2.7

中间件:MySQL

第三方包:pymysql/requests/

场景:小规模爬虫/一样平常爬虫

通过查看FOFA API可以得知要求地址和参数,开局一句话功能全靠编。

要求中央

在发送大量的http要求时最好利用统一的HTTP要求中央,方便掌握,代码重复利用,提高效率。

session = requests.session()# 要求头headers = { 'Upgrade-Insecure-Requests': '1', 'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.110 Safari/537.36'}'''要求中央,掌握程序所有HTTP要求,如果要求发生缺点进行考试测验再次连接@param url 要求连接home.php?mod=space&uid=126298 要求相应结果'''def fofa_requests(url): rs_content = '' while True: try: rs = session.get(api_url, verify=False,headers=headers) rs_text = rs.text results = json.loads(rs_text) total_size = results['size'] error = results if results['error'] and 'None' not in results['error']: info = u'fofa 缺点:'+results['error']+u' 休眠30s' logging.error(info) time.sleep(30) else: rs_content = results except Exception as e: logging.error(u'fofa 缺点:'+str(e.message)+u' 休眠30s') traceback.print_exc() time.sleep(30) return rs_content

数据库存储

有了统一的要求中央接下来就该编写入库代码,将爬虫结果存入数据库中。

'''批量数据存入数据库@param results@param page_no 当前页数@param page_total 总页数'''def batch_insert_db(results,page_no,page_total,fofa_sql): try: Z = [] for result in results: a = (str(result[0]),str(result[1]),str(result[2]),str(result[3]),str(result[4]),str(result[5]),str(result[6]),pymysql.escape_string(fofa_sql)) Z.append(a) sql = \"大众INSERT IGNORE INTO fofa_spider(id,host,ip,port,protocol,country_name,region_name,city_name,fofa_sql,create_date,update_date) VALUES(DEFAULT,%s,%s,%s,%s,%s,%s,%s,%s,NOW(),NOW())\公众 cursor.executemany(sql, Z) connection.commit() logging.info(u'存入数据库ok,总数量为:'+str(len(Z))+u', page--> '+str(page_no)+'/'+str(page_total)) except Exception as e: logging.error(u\"大众存入数据库缺点,缺点信息:\公众+e.message) traceback.print_exc()

核心业务代码

可以存入数据库中就该写核心的函数逻辑函数,输入参数仅为FOFA检索语句。

'''fofa 爬虫主函数@param fofa_sql fofa查询语句'''def main(fofa_sql): base64_str = base64.b64encode(fofa_sql) fields_str = ','.join(fields) api_url = 'http://fofa.so/api/v1/search/all?email='+fofa_name+'&key='+fofa_key+'&fields='+fields_str+'&size='+str(page_size)+'&page='+str(page_start)+'&qbase64='+base64_str rs = fofa_requests(api_url) total_size = rs['size'] # 打算页数 page_end = total_size / page_size + 1 if total_size % page_size != 0 else total_size / page_size # 存入u 数据库 batch_insert_db(rs['results'],page_start,page_end,fofa_sql) for page_no in range(1,page_end+1): api_url = 'http://fofa.so/api/v1/search/all?email='+fofa_name+'&key='+fofa_key+'&fields='+fields_str+'&size='+str(page_size)+'&page='+str(page_no)+'&qbase64='+base64_str batch_insert_db(rs['results'],page_start,page_end,fofa_sql)

程序运行结果:

完全代码地址:

https://github.com/0nise/scripts/blob/master/fofa_spider.py

注:运行脚本之前先配置干系配置信息(数据库/FOFA信息)

进阶

问题

针对一样平常的数据爬虫,上述方法可以完美适应。但如果须要爬虫的是为千万级别规模的数据,上述方法就不适用了,办理方案一样平常有多线程/多进程/协程等。

思路

针对大规模数据爬虫,很多人想到的是多线程/多进程/协程等方案,但是这些方案的可扩展并不是很强,如果须要调度工具须要停滞程序修处死式等,这里我是利用生产者和消费的思路来处理。只须要对上述的代码做轻微修正就可以完美的适应大规模数据爬虫,这里我利用redis+celery的办法来实现。

Redis

Redis是一款开源的、高性能的键-值存储(key-value store)。它常被称作是一款数据构造做事器(data structure server)。

Redis的键值可以包括字符串(strings)类型,同时它还包括哈希(hashes)、列表(lists)、凑集(sets)和 有序凑集(sorted sets)等数据类型。 对付这些数据类型,你可以实行原子操作。例如:对字符串进行附加操作(append);递增哈希中的值;向列表中增加元素;打算凑集的交集、并集与差集等。

为了得到精良的性能,Redis采取了内存中(in-memory)数据集(dataset)的办法。同时,Redis支持数据的持久化,你可以每隔一段韶光将数据集转存到磁盘上(snapshot),或者在日志尾部追加每一条操作命令(append only file,aof)。

Redis同样支持主从复制(master-slave replication),并且具有非常快速的非壅塞首次同步( non-blocking first synchronization)、网络断开自动重连等功能。同时Redis还具有其它一些特性,个中包括大略的事物支持、发布订阅 ( pub/sub)、管道(pipeline)和虚拟内存(vm)等 。

Redis具有丰富的客户端,支持现阶段盛行的大多数编程措辞。

celery

简介

Celery(芹菜)是一个大略、灵巧且可靠的,处理大量的分布式系统,并且供应掩护这样一个别系的必需工具。

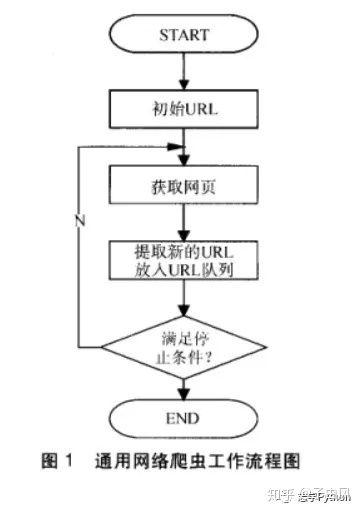

任务行列步队

任务行列步队是一种在线程或机器间分发任务的机制。

行列步队

行列步队的输入是事情的一个单元,称为任务,独立的职程(Worker)进程持续监视行列步队中是否有须要处理的新任务。

Celery 用通信,常日利用中间人(Broker)在客户端和职程间斡旋。这个过程从客户端向行列步队添加开始,之后中间人把派送给职程,职程对进行处理。如下图所示:

Celery 系统可包含多个职程和中间人,以此得到高可用性和横向扩展能力。

架构

Celery的架构由三部分组成,中间件(message broker),任务实行单元(worker)和任务实行结果存储(task result store)组成。

中间件

Celery本身不供应做事,但是可以方便的和第三方供应的中间件集成,包括,RabbitMQ,Redis,MongoDB等,这里我先去理解RabbitMQ,Redis。

任务实行单元

Worker是Celery供应的任务实行的单元,worker并发的运行在分布式的系统节点中。

任务结果存储

Task result store用来存储Worker实行的任务的结果,Celery支持以不同办法存储任务的结果,包括Redis,MongoDB,Django ORM,AMQP等,这里我先不去看它是如何存储的,就先选用Redis来存储任务实行结果。

修正

添加celery配置信息

'''Celery'''from celery import platforms,Celeryplatforms.C_FORCE_ROOT = True# Redis连接地址,如果为本机不须要做修正broker = 'redis://127.0.0.1:6379/0'app = Celery('fofa_spider',broker=broker)

添加核心函数

'''celery 爬虫@param api_url 爬虫URL@param fofa_sql FOFA语句'''@app.taskdef celery_spider(api_url,fofa_sql): rs = fofa_requests(api_url) batch_insert_db(rs['results'],fofa_sql)

修正业务逻辑代码

'''fofa 爬虫主函数@param fofa_sql fofa查询语句'''def main(fofa_sql): base64_str = base64.b64encode(fofa_sql) fields_str = ','.join(fields) api_url = 'http://fofa.so/api/v1/search/all?email='+fofa_name+'&key='+fofa_key+'&fields='+fields_str+'&size='+str(page_size)+'&page='+str(page_start)+'&qbase64='+base64_str rs = fofa_requests(api_url) total_size = rs['size'] # 打算页数 page_end = total_size / page_size + 1 if total_size % page_size != 0 else total_size / page_size # 存入数据库 batch_insert_db(rs['results'],fofa_sql) for page_no in range(1,page_end+1): api_url = 'http://fofa.so/api/v1/search/all?email='+fofa_name+'&key='+fofa_key+'&fields='+fields_str+'&size='+str(page_size)+'&page='+str(page_no)+'&qbase64='+base64_str logging.info('send task -->'+api_url) celery_spider.delay(api_url,fofa_sql)

完全代码地址:

https://github.com/0nise/scripts/blob/master/fofa_spider_ext.py

运行

运行python fofa_spider_ext.py发送须要爬虫的任务信息

运行celery -A fofa_spider_ext worker -l info进行消费爬虫

运行成功

数据库信息