曾有一位北大硕士生,在校期间一次性在国际顶会ACL中标8篇论文,个中2篇一作,还登上了知乎热搜。

在那次热搜之后,这位“论文大户”彷佛逐渐偃旗息鼓。

本日,她带着阿里达摩院深度措辞模型体系AliceMind回来了。

这位被外界称为“AI萝莉”的罗福莉,就卖力这次AliceMind中7个模型的开源。

她的经历提及来有点“传奇”。

上大学之前没怎么打仗过电脑,却误打误撞进了北师大打算机专业。

刚入学时因没有根本成绩垫底,靠着努力跃升到前一、二名。

大三时进入北大措辞打算实验室演习,选择了NLP作为自己的科研方向,在3个月内自学Python并投出一篇顶会论文(非一作)。

保研进入北大,硕士两年间在国际顶会上揭橥了超过20篇论文。

但她出人意料地没有选择连续读博,而是在2020年毕业之后就加入了阿里达摩院,想做点实在的研究。

进入工业界这两年,她发的论文明显减少了。

在读书的时候,周围的评价机制都是非常在意你的论文数量。但是到工业界,我现在已经不追求数量了,紧张是追求做这个事情是不是真的有落地代价,是不是在这个领域有一些影响力。

她在达摩院主导开拓了跨措辞预演习模型VECO,成为AliceMind八大模型之一。这次AliceMind集体开源,她挑起了大梁。

大略的才是最赞的

罗福莉在业界事情这一年,与在学术界时比较心态上有了很大的转变:

在学校的时候总是追求提出一个很繁芜的模型,大家看不懂,论文评审人也看不懂,但是到工业界的时候就会创造一眼就能看懂并且还有效的模型才是最赞的。

这也是她所在的达摩院深度措辞模型团队的思路,他们打造的AliceMind八大模型先后登顶了GLUE、CLUE、XTREME、VQA Challenge、DocVQA、MS MARCO六大NLP威信榜单。

AliceMind中Alice的含义实在很大略,便是Alibaba’s Collection of Encoder-decoders。

个中的模型也像这个名字一样朴实,都是从实际业务须要出发,在Encoder-decoder的根本上进行创新和改进。

通用措辞模型StructBERT,在BERT的根本上增加了词级别和句级别的两个新目标函数,相称于让AI节制了“汉字序顺不响影读阅”这个能力。

这是由于团队在阿里的业务中创造,用户在电商、娱乐产品等轻松地利用场景时,常常涌现语法、语序禁绝确等征象。

这就须要让措辞模型在面对语序错乱、语法不规范的词句时,仍能准确理解并给出精确的表达和回应。

AliceMind刚刚还再次登顶了多模态威信榜单VQA Challenge 2021。

VQA Challenge的比赛任务类似看图问答,给定一张图像和关于图像的自然措辞问题,AI须要供应准确的自然措辞答案。

对此,AliceMind的多模态模型StructVBERT,在通用模型StructBERT的根本上,同时引入文本和图像模态。

利用更高效的视觉特色和创新的交叉把稳力机制,在统一的多模态语义空间进行联合建模。

除了跨模态,罗福莉主导的跨措辞模型VECO也被顶会ACL2021任命。

VECO中也引入了交叉把稳力机制,改变了以往跨措辞信息在隐蔽层中自动建模的不稳定性,而是“显式”地完成。

VECO的另一项创新是在预演习的过程中,充分学习用于措辞理解(NLU)和天生(NLG)任务,并让二者相互学习提高彼此。

如今罗福莉再回顾VECO这个事情,也有一些感慨:

如果是两年前还在学校的我,会以为这好大略,我可以加上很多的花式技巧。但是到了工业界要考虑到架构在不同业务场景下的通用性,只好捐躯一些繁芜有趣的模型设计。

AliceMind中的天生式措辞模型PALM,则是将预演习目标从重构输入文本,改成了预测后续文本。

这样一个改动就匆匆使模型对输入文本进行更深入地理解,在问答天生、文本复述、回答天生、文本择要等任务上都取得了更好的效果。

还有构造化措辞模型StructuralLM、机器阅读理解模型UED和知识驱动的措辞模型LatticeBERT,都在各自的领域取得了明显地上风。

除了这次开源的7个模型,AliceMind中还包括了超大规模中文理解和天生统一模型PLUG。

AliceMind中的模型,看起来有一个共同特点,便是善于”跨界“。

从跨措辞、跨模态到措辞理解和天生的统一,都是基于Transformer架构将不同地输入在一个更大的编码空间上统一建模。

罗福莉补充道:

AliceMind的这种将Transformer作为统一模型架构的办理方案已经比较成熟,但要做到更好“跨界”,接下来努力的方向是办理不同类型或粒度输入的深度领悟和匹配问题。

从根本模型扩展出能力多样的模型,再把它们在实际业务中结合利用,让AliceMind成了业界能力最全面的深度措辞模型体系。

那么AliceMind都用到了哪些地方?

落地是个别系化的工程AliceMind已经上线到阿里内部的NLP平台,可以供应给不同部门的业务利用。

在官方网站上也供应了Demo,比如这个基于PLUG模型的措辞天生模块。

输入红楼梦选段:

就能天生一段续写:

而像这样可供大家试玩的Demo还有几十个。

不过这些官网上的做事并非都是由AliceMind供应技能支持,很多都只是这一体系启示下的小模型。

那么这次开源的几大核心目前都在哪里打工呢?

运用最广泛的,便是电商。

尤其是阿里巴巴国际奇迹部(ICBU)或像速卖通(AliExpress)这样拥有跨境电商业务的部门,便是多措辞模型VECO的直接管益者。

VECO是AliceMind体系中的8大模型之一,用于多措辞理解和跨语种的文本嵌入、分类,节制了100多种措辞。

阿里内部基于AliceMind的翻译平台日调用量约10亿次,创造了数亿美元的国际跨境贸易和其他国际业务商业代价。

就像达摩院深度措辞模型团队卖力人黄松芳所说“措辞模型落地是个别系化的工程”:

措辞模型从演习、微调到蒸馏、压缩,到全体支配上线都在平台上面完成,上线之后跟业务方的系统连在一起,能够直接嵌到他们的业务逻辑、业务系统里面去。

我们更熟习的淘宝拍照识图、天猫精灵智能音箱中也有AliceMind的贡献。

目前,AliceMind已经在阿里内部数十个核心业务落地,日均调用50亿次,生动场景超过200个。

在阿里之外,医疗领域尤其是癌症治疗上,AliceMind同样着力不少。

作为一个具有自主学习能力的深度学习措辞模型体系,AliceMind运用在搜索引擎上时会有一个重排机制。

以详细某一类医学文献为目标,AliceMind在粗排先捞了一批干系文本后,还会再次结合文章类型、引用图谱等信息,进行不断地重排。

同时将抽取得到的信息与已知的构造化知识做领悟,构建知识体系,终极得到最高质量的临床文献。

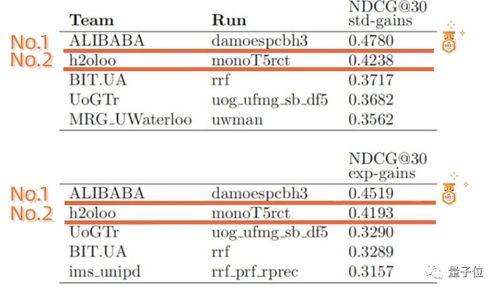

在最近16支天下有名团队参加的精准医学国际评测中,凭借这一精准医学搜索引擎,阿里团队在两项临床证据质量评估上均取得第一:

这样高精度的专业医学搜索引擎能够在疾病治疗时,为临床年夜夫做供应高质量的临床决策赞助。

法律领域也有AliceMind的出没。

浙江省高等公民法院就与达摩院互助,实现了从备案到裁判文诗人成的全流程智能化审判系统。

而在这一试点单位中,AI对法官事情量的分担使当庭宣判率提升至90%,结案韶光也从均匀40天缩短到50分钟。

现在,基于AliceMind的AliNLP平台日均累计调用量超过数万亿次,每天有超过每天有超过1000个业务方利用。

电商、教诲、医疗、能源,通信、法律、内容搜索、城市大脑……越来越多的领域在AliceMind的加入下变得更加便利,更加智能。

开源之后要做什么?现在,预演习措辞模型目前在NLP领域以及全体学习界都非常热门,超大规模参数的模型已成为一种趋势。

对此,达摩院深度措辞模型团队的卖力人,也是AliceMind的总卖力人黄松芳表示:

我们这边实在不会一味地追求大,而是非常强调它的落地。

一个措辞模型从研究开拓到投入实际运用,不是一家企业就能做到的。

还须要全体社区的开拓者都参与,才有可能将学术论文中的公式算法用到大家的生活便利上。

达摩院希望通过开源,能降落业界研究和创新运用的门槛,使措辞AI进入大工业时期。

下一步,AliceMind打算与措辞学、神经科学等跨学科的单位加强互助,将措辞AI扩展到更大的运用中。

开源地址:https://github.com/alibaba/AliceMind

AliceMind官网:https://nlp.aliyun.com/portal#/alice

干系论文:

通用预演习模型StructBERT:https://arxiv.org/abs/1908.04577

多措辞预演习模型VECO:https://arxiv.org/abs/2010.16046

天生式预演习模型PALM:https://arxiv.org/abs/2004.07159

多模态预演习模型E2E-VLP:https://arxiv.org/abs/2106.01804

构造化预演习模型StructuralLM:https://arxiv.org/abs/2105.11210

阅读理解模型:https://ojs.aaai.org/index.php/AAAI/article/view/16584

领悟知识的预演习模型Lattice-BERT:https://arxiv.org/abs/2104.07204

参考链接:[1]https://mp.weixin.qq.com/s/LTVVOOhezUN96MRLrqKCAQ[2]https://mp.weixin.qq.com/s/PW0wZbts6ZpbKZSHyp8aVw

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一韶光获知前沿科技动态