RGBD图片相对付完全场景而言,能够轻松获取,并且使得文本视觉定位能够在动态变革的环境及时进行(如演示视频),不须要每次都重修完全场景。但由于物体几何信息的部分缺失落,在RGBD图片上进行三维文本视觉定位是更有寻衅性的任务。我们提出了一个自下而上的方法,来办理这一任务所带来的寻衅。

论文链接:

https://arxiv.org/abs/2103.07894

项目主页:

https://unclemedm.github.io/Refer-it-in-RGBD/

一、文章思路1. 我们提出了一项新颖而具有寻衅性的任务——在存在不完全的信息或部分遮挡的单视图RGBD图像中,根据文本描述进行三维物体定位(3D visual grounding)。

2. 我们提出了一种内容感知(content-aware),自下而上(bottom-up)的方法,在ScanRefer数据集和我们新网络的数据集SUNRefer上,分别得到了优于现有方法11.2%和15.6%的结果。

3. 我们为3D visual grounding供应了一个大规模的基于RGBD图像的物体文本描述数据集。

二、SUNRefer数据集由于短缺单视角RGBD图片下专用于3D visual grounding的大规模数据集,我们贡献了一个基于SUN-RGBD数据集的物体文本标注数据集,称为SUNRefer。我们的数据集包含来自SUN-RGBD的7,699个RGBD图像和我们所贡献的38,495个描述。

数据比较:图1中显示了SUNRefer数据集的示例。表1中展示了与其他文本三维视觉定位数据集的比较。

图 1:SUNRefer数据集样本

表 1:SUNRefer数据集的统计信息,和其他公开的文本三维视觉定位数据集的比较

三、任务概述基于单视角(single-view)RGBD图片的文本三维视觉定位(3D visual grounding)任务: 我们首次提出在单视角(single-view)RGBD图片上完成文本三维视觉定位任务(3D visual grounding),即给出一张单视角RGBD图片和一个针对该图片上某个物体的文本描述,找出该文本描述对应的物体,并给出其3d bounding box,图2是该任务的一个例子。本任务中须要考虑的一个难点是,输入的图片存在信息不完全或者部分遮挡的情形,图3给出了一个例子,此时图片只包含文本描述中的目标物体的一部分,在这种情形下,将不完全的三维视觉信息与文本描述进行匹配,从缺失落的不雅观察中得到完全的bounding box,都将变得十分困难。

图 2

图 3

四、网络框架本文提出了一个自下而上(bottom-up)的方法来办理寻衅。该框架包含两个紧张模块——体素级别匹配和粗略定位(Voxel-level Matching for coarse localization),以及物体级别的风雅文本定位(object-level matching for fine grounding)。首先进行体素级别匹配天生干系性热力争(relevancy heatmap),用于在RGBD图片中粗略地定位到所描述物体的干系区域。接下来,在物体级别的模块中,本文提出了一种自适应搜索策略,基于干系性热力争在重点干系区域进行更细致地搜索。末了,我们将自适应搜索中积累的特色与措辞特色进行领悟,以进行物体级别匹配,天生多个3d bounding boxes和每个bounding box 与措辞的匹配分数(matching score)。图4展示了我们的网络构造。

图 4:网络构造

体素级别匹配(voxel-level matching):首先我们对两个模态的输入——文本和RGBD图片——进行体素级别的匹配以粗略确定物体的位置。

天生干系性热力争我们首先将输入的RGBD图片转换为体素,然后采取U-Net模型,并在瓶颈层融入语句特色,来终极得到逐体素的干系性热力争(如图4的所示,高亮区域与输入的措辞描述有高干系性)。为了方便后续在点云上进行操作,我们将热力争再投影到点云上,终极得到点云上的热力争。物体级别匹配(object-level matching):我们利用天生的干系性热力争来实行更细粒度的物体定位。我们首先提出一个文本感知的采样方法,以天生种子点(seed),使得这些种子点集中在干系性热力争中高亮的区域,再以每个种子点为中央对周围区域进行细致的搜索。然后,我们将种子点的特色和措辞特色进行领悟,并利用VoteNet中所提出的Voting Module来回归出多个候选bounding boxes以及每个bounding box与输入语句的匹配分数。

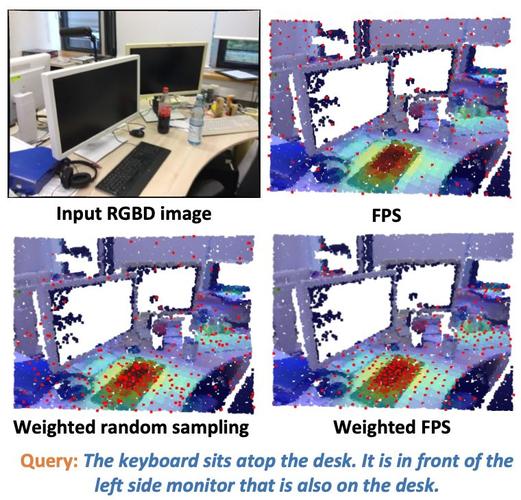

自适应的采样方法本文提出利用加权最远点采样(weighted FPS)来得到种子点。详细来说,我们利用干系性热力争作为点云中每个点的权重,然后结合最远点采样,给两个点之间的间隔作加权。这种采样方法可以确保具有较高热力值的点有较高的机会当选中,从而导致种子点密集分布在热力争的高亮区域中。在得到种子点后,我们从之前利用Pointnet++处理得到的关键点特色中通过特色聚合(feature aggregation)获取种子点的特色。视觉措辞特色领悟天生proposal在这一步中,我们再次进行文本特色和种子特色的领悟。然后我们采取和VoteNet相同的机制,每个seed通过vote找到附近物体的中央点,再通过聚类得到proposal特色。末了我们利用MLP从proposal 特色回归出3d bounding box和每个3d bounding box与输入文本的匹配分数,个中匹配分数最高的被我们选为终极的预测结果。丢失函数(loss function):Heatmap loss: 本文利用了Heatmap loss来监督干系性热力争的天生,利用了Gaussian kernel来天生GT 热力争,区域离目标物体的中央越远,GT热力值越低。

Vote loss: 我们参照VoteNet定义了Vote loss来匆匆使网络天生精确的vote。

Matching loss: 我们设计了matching loss用于衡量匹配分数和IoU(候选bounding box与GT bounding box的IoU)之间的关系,通过这种办法可以使得匹配分数瞄准确的候选bounding box做出高度相应,公式如下,

Response loss: 为了拉近与GT bounding box IoU最高的候选bounding box和GT bounding box的间隔,我们设计了response loss,公式如下,

五、实验与剖析

单视角RGBD数据集: 在实验部分,我们分别在ScanRefer上的单视角RGBD数据集和我们自己网络的SUNRefer数据集上进行了演习和测试。个中,由于ScanRefer只供应了在全场景上的标注,以是对付每一个标注的物体,我们直接从ScanNet上提取了包含该物体的原始RGBD图片。在演习中,选取的图片包含遮挡程度不同的目标物体,使得我们的方法也可以处理严重遮挡情形下的物体。

我们选择了ScanRefer中提出的方法,和两个二维visual grounding的方法并把二维结果投影到三维空间,作为比拟。实验的数值结果如表2所示,显示我们的方法在两个数据集上都有明显优于现有方法的结果。我们也选取了部分实验可视化结果,如图5所示。

表 2

图 5:如果bounding box和GT bounding box(黄色)的IoU大于0.5,则将其视为成功的预测(绿色);否则,将其视为失落败的预测(赤色)

Whole scene数据集: 同时,我们也在全场景的ScanRefer数据集上进行了演习和测试,以跟ScanRefer完备相同的设置下进行实验比拟。结果显示我们的方法不仅适用于单视角的RGBD图片,在全场景数据上也有较好的表现,在相同的输入条件下能够得到明显优于现有方法的结果。表3展示的是与目前表现最好的方法在ScanRefer数据集上的定量比较。

表 3:与在ScanRefer数据集上的目前最优方法的定量比较。纵然是在全场景的设定下,我们的方法均取得了更好或者水平相称的结果

溶解实验为了证明我们提出的网络构造的有效性,我们同时进行了溶解实验。

没有体素级别匹配的FPS baseline: 在没有利用voxel-level匹配的FPS Baseline的方法中,我们只利用了一个标准的VoteNet和前文提到的物体级别匹配, 从表4和图6可以看出加上voxel-level的效果明显好于FPS baseline。

表 4:溶解研究的定量结果

图 6:我们的方法与FPS baseline的比较。绿色为成功的预测,赤色为失落败的预测,黄色为GT bounding box

只利用体素级别匹配: 在这个方法中,我们移除了物体级别的匹配,我们同样利用VoteNet来天生物体proposal,同时根据天生的点云Heatmap来选择与文本匹配置信度最高的proposal作为终极结果。从表4中可以看出,去掉物体级别匹配会使结果大幅度降落。

利用不同的采样策略: 我们比较了不同的采样方法,包括标准的最远点采样,我们利用的加权最远点采样,和将热力值作为采样概率的随机采样。从图7可以看出, 在加权最远点采样中,点能够更多地落在与目标物体干系的区域内,并且是均匀分布的,由此可以得到更好的效果。表4中有不同采样方法的定量比较。

图 7:不同采样方法之间的比较。seed以赤色显示

利用不同的策略天生干系性热力争: 我们比拟了基于点云、基于图片和基于体素天生热力争的方法,从图8可以看出,利用体素可以天生更加贴近目标物体的Heatmap, 使得在后续可以提取到更好的内容感知特色以得到更准确的3d bounding box。表4中有上述不同策略的定量比拟。

图 8:干系性热力争天生模型中利用不同模态的方法之间的比较。绿色为成功的预测,赤色为失落败的预测,黄色为GT bounding box

六、总结我们提出了一个全新的任务,即单视角RGBD下的文本三维视觉定位。我们也提出了一个自下而上的方法,分别在voxel-level和object-level进行视觉和文本的匹配。同时,我们贡献了一个大规模的文本视觉定位数据集SUNRefer,该数据集包含超过7000张图片和38495条描述。通过实验,证明我们的方法在SUNRefer和ScanRefer数据集上都能得到大幅度优于之前的方法的结果。

//

团队先容

项目紧张由喷鼻香港中文大学(深圳)GAP实验室韩晓光博士带领主导完成。该事情紧张完成人刘浩霖,为喷鼻香港中文大学(深圳)博士生。

GAP实验室:

https://mypage.cuhk.edu.cn/academics/hanxiaoguang/index.html

- The End -

关于我“门”

将门是一家以专注于发掘、加速及投资技能驱动型创业公司的新型创投契构,旗下涵盖将门创新做事、将门技能社群以及将门创投基金。

将门成立于2015年底,创始团队由微软创投在中国的创始团队原班人马构建而成,曾为微软优选和深度孵化了126家创新的技能型创业公司。

如果您是技能领域的初创企业,不仅想得到投资,还希望得到一系列持续性、有代价的投后做事,欢迎发送或者推举项目给我“门”: bp@thejiangmen.com