第一部分:Linux环境中手动安装和配置Kafka集群:

1、下载Kafka:

访问Apache Kafka官网(https://kafka.apache.org/downloads)下载适宜你的Linux系统的Kafka版本。界面如下:

2、上传并解压文件:

将下载的.tgz文件上传到所有将作为Kafka Broker节点的Linux做事器上。

解压文件,例如:

tar -zxvf kafka_2.13-3.6.1.tgz

mv kafka_2.13-<version> kafka

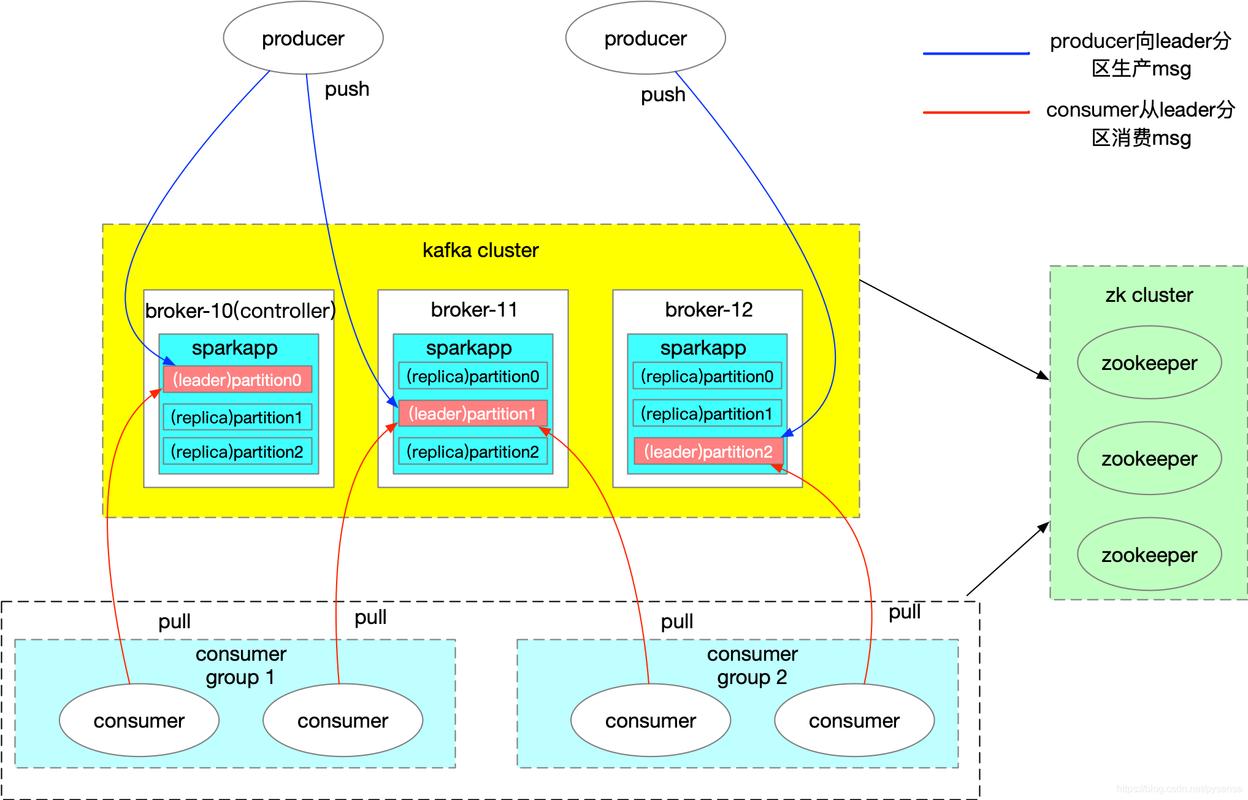

配置ZooKeeper:Kafka集群的正常事情须要依赖ZooKeeper。您须要配置ZooKeeper,并确保每台Kafka机器都可以访问ZooKeeper。在每台机器上,编辑Kafka的配置文件(常日位于/etc/kafka/server.properties),并设置以下属性:

zookeeper.connect=hadoop1:2182

3、配置Kafka Broker:

进入解压后的kafka/config目录,编辑server.properties文件。

配置broker.id,每个Broker必须有一个唯一的ID。

设置log.dirs,指定Kafka数据存储位置。

如果是集群支配,配置listeners以监听得当的网络接口和端口,常日设置为PLAINTEXT://:9092或其他端口。

对付集群内部通讯,配置advertised.listeners,确保其他Broker和客户端可以找到该Broker。

配置Zookeeper连接地址,如zookeeper.connect=localhost:2182,server2:2182,server3:2182,利用实际的Zookeeper节点地址和端口。

配置Zookeeper(如果尚未支配):在每个运行Zookeeper的做事器上,编辑zookeeper.properties文件,配置Zookeeper集群信息。

修正dataDir指向日志存放地址,并配置server.x参数来标识各个Zookeeper节点。

4、启动Zookeeper集群:

在每个Zookeeper节点下实行启动命令:

bin/zookeeper-server-start.sh config/zookeeper.properties

启动Kafka集群:

5、在每个Kafka Broker节点下实行启动命令:

bin/kafka-server-start.sh config/server.properties

6、创建Topic(可选,但常日是必要的):

可以通过Kafka供应的命令行工具创建topic:

bin/kafka-topics.sh --create --bootstrap-server localhost:9092 --replication-factor 3 --partitions 3 --topic my-topic

第二部分:如何利用Python实现kafka集群支配,先安装下面的依赖包

要利用Python实现Kafka集群的支配,你可以遵照以下步骤:

1、安装Python和干系依赖:确保你的系统上已经安装了Python和所需的依赖项,如pip。你可以利用以下命令安装pip:

2、shell实现:sudo apt-get install python3-pip

3、安装Kafka Python客户端:利用pip安装Kafka的Python客户端库,如confluent-kafka-python或kafka-python。你可以利用以下命令安装confluent-kafka-python:

shell实现: pip3 install confluent-kafka

4、配置Kafka集群:在每台Kafka机器上,编辑Kafka的配置文件(常日位于/etc/kafka/server.properties),并设置以下属性:

broker.id:每个Kafka broker的唯一标识符。

log.dirs:Kafka的日志目录。

以下是一个大略的Python脚本示例,用于在Linux环境下实行基本的Kafka集群安装:

import subprocess

# 定义Kafka版本和下载链接

kafka_version = "2.8.1"

download_url = f"https://downloads.apache.org/kafka/{kafka_version}/kafka_2.13-{kafka_version}.tgz"

# 下载并解压Kafka

subprocess.run(["wget", download_url])

subprocess.run(["tar", "-xzf", f"kafka_2.13-{kafka_version}.tgz"])

# 配置Kafka集群

kafka_dir = f"kafka_2.13-{kafka_version}"

subprocess.run(["cp", f"{kafka_dir}/config/server.properties", f"{kafka_dir}/config/server-1.properties"])

subprocess.run(["cp", f"{kafka_dir}/config/server.properties", f"{kafka_dir}/config/server-2.properties"])

# 修正配置文件以配置集群

subprocess.run(["sed", "-i", "s/broker.id=0/broker.id=1/", f"{kafka_dir}/config/server-1.properties"])

subprocess.run(["sed", "-i", "s/broker.id=0/broker.id=2/", f"{kafka_dir}/config/server-2.properties"])

# 启动Kafka集群

subprocess.Popen(["./kafka_2.13-{kafka_version}/bin/kafka-server-start.sh", "-daemon", f"{kafka_dir}/config/server.properties"])

subprocess.Popen(["./kafka_2.13-{kafka_version}/bin/kafka-server-start.sh", "-daemon", f"{kafka_dir}/config/server-1.properties"])

subprocess.Popen(["./kafka_2.13-{kafka_version}/bin/kafka-server-start.sh", "-daemon", f"{kafka_dir}/config/server-2.properties"])

5、验证安装:要验证Kafka集群是否成功安装和运行,你可以实行以下步骤:

创建一个新的Topic:利用Kafka的管理工具或命令行界面,创建一个新的Topic。例如,利用以下命令创建一个名为test-topic的Topic:

kafka-topics.sh --create --zookeeper hadoop1:2181 --replication-factor 1 --partitions 1 --topic test-topic

发送和吸收:利用Kafka的生产者和消费者工具,向新创建的Topic发送和吸收。例如,利用以下命令创建一个消费者并订阅Topic:

php

kafka-console-consumer.sh --zookeeper hadoop1:2181 --topic test-topic --from-beginning

这将显示从Topic中拉取的。现在,利用生产者工具发送到Topic,并在消费者端查看。

6. 可视化工具:你还可以利用可视化工具来监视和管理Kafka集群。例如,Offset Explorer是一个盛行的可视化工具,可用于查看和管理Kafka中的偏移量。你可以根据可视化工具的文档进行安装和配置。