量子位 | 公众号 QbitAI

大模型力大砖飞,让LLaMA3演绎出了新高度:

超15T Token数据上的超大规模预演习,既实现了令人印象深刻的性能提升,也因远超Chinchilla推举量再次引爆开源社区谈论。

与此同时,在实际运用层面上,另一个热点话题也浮出水面:

资源有限场景下,LLaMA3的量化表现又会如何?

喷鼻香港大学、北京航空航天算夜学、苏黎世联邦理工学院联合推出了一项实证研究,全面揭示了LLaMA3的低比特量化性能。

研究职员利用现有的10种演习后量化和LoRA微调方法,评估了LLaMA3在1-8比特和各种评估数据集上的结果。他们创造:

只管性能令人印象深刻,LLaMA3在低比特量化下仍旧遭受了不可忽略的退化,特殊是在超低位宽上。

项目已在GitHub上开源,量化模型也已上岸HuggingFace。

详细来看实证结果。

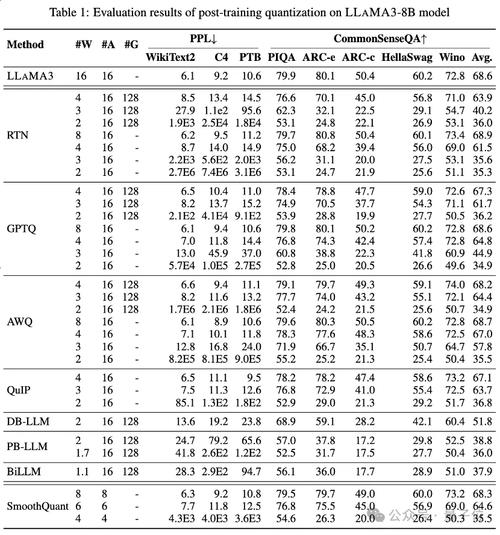

轨道1:演习后量化表1和表2等分别供应了LLaMA3-8B和LLaMA3-70B在8种不同的PTQ方法下的低比特性能表现,覆盖了从1比特到8比特的广泛比特宽度。

1.低比特权重

个中,Round-To-Nearest (RTN) 是一种基本的舍入量化方法。

GPTQ是当前最有效率和有效的仅限权重的量化方法之一,它利用量化中的偏差补偿。但在2-3比特下,当量化LLaMA3时,GPTQ会导致严重的准确性崩溃。

AWQ采取非常通道抑制方法来降落权重量化的难度,而QuIP通过优化矩阵打算来确保权重和Hessian之间的不一致性。它们都能保持LLaMA3在3比特时的能力,乃至将2比特量化推向有希望的水平。

2.超低比特权重

最近涌现的二值化LLM量化方法实现了超低比特宽度LLM权重压缩。

PB-LLM采取稠浊精度量化策略,保留一小部分主要权重的全精度,同时将大部分权重量化为1比特。

DB-LLM通过双重二值化权重分割实现高效的LLM压缩,并提出偏差感知蒸馏策略以进一步增强2比特LLM性能。

BiLLM通过显著权重的残差逼近和非显著权重的分组量化,进一步将LLM量化边界推低至1.1比特。这些为超低比特宽度专门设计的LLM量化方法可以实现更高精度的量化LLaMA3-8B,在⩽2比特时远远超过如GPTQ、AWQ和QuIP等方法,在2比特(乃至在某些情形下3比特)下的表现。

3.低比特量化激活

还通过SmoothQuant对量化激活进行了LLaMA3评估,SmoothQuant将量化难度从激活转移到权重,以平滑激活非常值。评估显示,SmoothQuant可以在8比特和6比特的权重和激活下保留LLaMA3的准确性,但在4比特时面临崩溃。

轨道2:LoRA微调量化

在MMLU数据集上,对付LoRA-FT量化下的LLaMA3-8B,最显著的不雅观察是,在Alpaca数据集上低秩微调不仅不能补偿量化引入的缺点,乃至使性能低落更加严重。

详细来说,各种LoRA-FT量化方法在4比特下得到的量化LLaMA3性能,比没有利用LoRA-FT的4比特对应版本要差。这与LLaMA1和LLaMA2上的类似征象形成光鲜比拟,在LLAMA1和LLAMA2中,4比特低秩微调量化版本乃至能轻松超过MMLU上的原始FP16对应版本。

根据直不雅观剖析,这一征象的紧张缘故原由是由于LLaMA3强大的性能得益于其大规模的预演习,这意味着原始模型量化后的性能丢失不能通过在一小部分低秩参数数据上进行微调来补偿(这可以被视为原始模型的一个子集)。

只管量化导致的显著低落不能通过微调来补偿,但4比特LoRA-FT量化的LLaMA3-8B在各种量化方法下显著优于LLaMA1-7B和LLaMA2-7B。例如,利用QLoRA方法,4比特LLaMA3-8B的均匀准确率为57.0(FP16: 64.8),超过4比特LLaMA1-7B的38.4(FP16: 34.6)18.6,超过4比特LLaMA2-7B的43.9(FP16: 45.5)13.1。这表明在LLaMA3时期须要一种新的LoRA-FT量化范式。

在CommonSenseQA基准测试中也涌现了类似的征象。与没有利用LoRA-FT的4比特对应版本相比,利用QLoRA和IR-QLoRA微调的模型性能也有所低落(例如,QLoRA均匀低落2.8% vs IR-QLoRA均匀低落2.4%)。这进一步展示了在LLaMA3中利用高质量数据集的上风,而且通用数据集Alpaca并没有对模型在其他任务中的性能作出贡献。

结论这篇论文全面评估了LLaMA3在各种低比特量化技能(包括演习后量化和LoRA微调量化)中的性能。

此研究创造表明,只管LLaMA3在量化后仍旧展现出优胜的性能,但与量化干系的性能低落是显著的,乃至在许多情形下可以导致更大的低落。

这一创造突显了在资源受限环境中支配LLaMA3可能面临的潜在寻衅,并强调了在低比特量化背景下增长和改进的充足空间。通过办理低比特量化引起的性能低落,预期后续的量化范式将使LLMs在较低的打算本钱下实现更强的能力,终极推动代表性的天生式人工智能达到新的高度。

论文链接:https://arxiv.org/abs/2404.14047

项目链接:https://github.com/Macaronlin/LLaMA3-Quantizationhttps://huggingface.co/LLMQ

— 完 —

量子位 QbitAI · 头条号签

关注我们,第一韶光获知前沿科技动态约