源码自动采集的基本事理

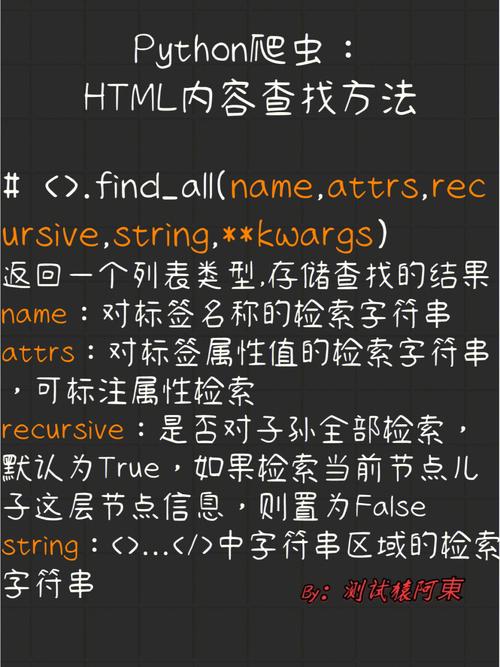

源码自动采集技能基于编程与网络爬虫事理布局,过程包括四大关键环节,即网页要求、HTML解析、信息抽取以及数据存储。首先,根据电脑指令,我们向特定站点发出HTTP要求以获取页面源代码;其次,借助诸如BeautifulSoup、XPath等解析器对HTML进行深入阐发,从而提纯所需信息;末了,对上述抽出的信息履行必要的处理及保存操作,方便未来剖析或展视。

源代码采集中紧张利用Python、Java、PHP等浩瀚编程措辞及对应库与框架(如Scrapy、Requests、Selenium等)。根据需求,程序员需挑选相应技能架构并利用其独特的技能与履历进行针对性研发。

源码自动采集的技能实现

在源代码自动采集过程中,面临诸多技能寻衅,如网页的多样性和动态加载内容问题。为战胜这些困难,研发职员需利用各种解析策略与工具,诸如正则表达式、CSS选择器以及XPath等,以此处理各种网页架构并知够数据获取哀求。

阻挡利用爬虫程序进行造孽操作是源代码自动网络面临的重大寻衅。为了抵御恶意爬虫对网站的威胁,许多网站已履行了IP约束、验证码筛选和User-Agent侦测等策略。因此,开拓职员必须深入理解和节制反反爬虫技能,以确保源代码网络过程的顺畅运行。

源码自动采集的运用处景

源代码抓取工具具有广泛适用性,知足各种行业所需。新闻媒体借此实现自动更新和发布;电子商务则通过网络竞品信息以开展价格监测及市场研究;至于金融做事业,可利用该技能对股市动态进行实时监控与剖析。

在此根本上,源代码自动化采集技能已在多个领域得到广泛运用,如舆论监控、搜索引擎优化及信息集成等方面。借助自适应的网络信息获取与解析功能,我们能帮忙客户迅速节制市场动态,挖掘商机潜力,从而提升事情效能与决策水准。

源码自动采集对信息获取和利用的影响

在源码采集领域的持续改造过程中,信息获取及运用实践始终面临深远影响。它们既推动了信息获取的速率与广度,利用户能够便捷地获取所需资讯;又引发了诸如信息质量和版权掩护等一系列问题。为了应对这些寻衅,我们须依照干系法律法规和前辈科技工具,对这些规范进行深入改进与有力保障。

利用源码自动检索技能,利用者可迅捷得到丰富且深入的数据剖析,这有助于强大的决策支持。如在商业环境中,企业得以深入理解行业竞争格局,有效调度计策支配;对科研职员而言,此技能能帮忙其广泛搜索学术文献,助力科研打破与学术影响力提升。

然而,源代码自动化网络仍面临诸多潜在问题与寻衅。首先,海量数据的获取有可能使网站做事器不堪重负,降落运行效率乃至导致系统崩溃。其次,造孽信息网络可能涉嫌陵犯他人知识产权,引发版权轇轕乃至法律诉讼。

面临的寻衅与未来展望

虽然源代码网络技能有了显著进展,但仍旧存在浩瀚难题。特殊是在日益严重的数据隐私与安全问题上,信息科技的发展使人们和企业更加重视数据保护。在此背景下,如何保障数据的合法合规网络就显得尤为主要。

未来不久,以人工智能及大数据为主导的崭新时期科技将不断拓展,源代码自动网络技能亦具有巨大的发展潜力。我们笃信,此项技能将持续改造,知足多样化需求,为广大用户供应更精确、更具个性的信息做事,助力信息家当持续发展。

结语

本文对自动文本抓取技能进行深度阐发,包括它所涉及的专业知识领域以及履行步骤,详细解析了此项技能如何运行及实际利用情形,以及可能带来的深远影响。希望通过这篇文章,读者可以更深入地理解并节制这项技能,从而有效提高数据的网络和利用效率。

深度阐发代码自动采集这一主要领域,将有力地提升我们的科技实力,欢迎浩瀚寻衅,同时也为社会的繁荣与公民幸福贡献力量。愿我们携手迈向未来,期待代码自动采集技能连续创新打破,推动人类共享美好前景。