IO多路复用是指 内核 一旦创造进程指定的一个或者多个IO条件准备读取,它就通过该 进程 ,目前支持I/O多路复用的系统调用有 select 、 poll 、 epoll ,I/O多路复用便是通过一种机制,一个进程可以监视多个描述符(socket),一旦某个描述符就绪(一样平常是读就绪或者写就绪),能够通过程序进行相应的读写操作。

描述符(socket)在windows中可以叫做句柄。我们可以理解成一个文件对应的ID。IO实在便是对

可以先看以前写的文章: 对同步 异步 壅塞 非壅塞在网络中的理解

壅塞IO:要求进程一贯等待IO准备就绪。

非壅塞IO:要求进程不会等待IO准备就绪。

同步IO操作:导致要求进程壅塞,直到IO操作完成。

异步IO操作:不导致要求进程壅塞。

举个小例的来理解壅塞,非壅塞,同步和异步的关系,我们知道编写一个程序可以有多个函数,每一个函数的实行都是相互独立的;但是,对付一个程序的实行过程,每一个函数都是必须的,那么如果我们须要等待一个函数的实行结束然后返回一个结果(比如接口调用),那么我们说该函数的调用是壅塞的,对付至少有一个函数调用壅塞的程序,在实行的过程中,必定存在壅塞的一个过程,那么我们就说该程序的实行是同步的,对付异步自然便是所有的函数实行过程都是非壅塞的。

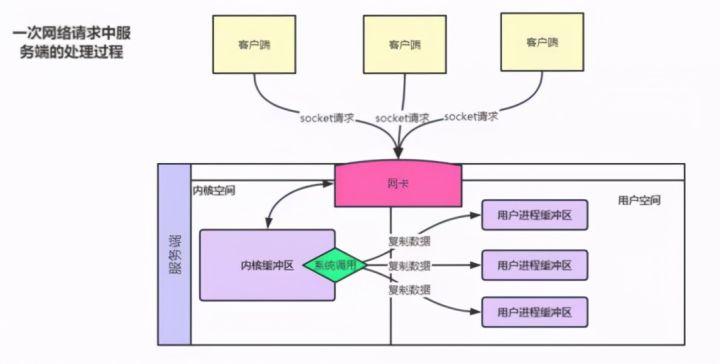

这里的程序便是一次完全的IO,一个函数为IO在实行过程中的一个独立的小片段。我们知道在Linux操作系统中内存分为 内核空间 和 用户空间 ,而所有的IO操作都得得到内核的支持,但是由于用户态的进程无法直接进行内核的IO操作,以是内核空间供应了系统调用,使得处于用户态的进程可以间接实行IO操作,IO调用的目的是将进程的内部数据迁移到外部即输出,或将外部数据迁移到进程内部即输入。而在这里谈论的数据常日是socket进程内部的数据。

1.3 五种IO模型基本事理在上图中,每一个客户端会与做事端建立一次socket连接,而做事端获取连接后,对付所有的数据的读取都得经由操作系统的内核,通过系统调用内核将数据复制到用户进程的缓冲区,然后才完成客户真个进程与客户真个交互。那么根据系统调用的办法的不同分为壅塞和非壅塞,根据系统处理运用进程的办法不同分为同步和异步。

模型1:壅塞式IO每一次客户端产生的socket连接实际上是一个文件描述符fd,而每一个用户进程读取的实际上也是一个个文件描述符fd,在该期间的系统调用函数会等待网络要求的数据的到达和数据从内核空间复制到用户进程空间,也便是说,无论是第一阶段的IO调用还是第二阶段的IO实行都会壅塞,那么就像图中所画的一样,对付多个客户端连接,只能开辟多个线程来处理。

模型2:非壅塞IO模型对付壅塞IO模型来说最大的问题就表示在壅塞2字上,那么为理解决这个问题,系统的内核因此发生了改变。在内核中socket支持了非壅塞状态。既然这个socket是不壅塞的了,那么就可以利用一个进程处理客户真个连接,该进程内部写一个去世循环,不断的讯问每一个连接的网络数据是否已经到达。此时轮询发生在用户空间,但是该进程依然须要自己处理所有的连接,以是该期间为同步非壅塞IO期间,也即为NIO。

模型3:IO多路复用在非壅塞IO模型中,虽然办理了IO调用壅塞的问题,但是产生了新的问题,如果现在有1万个连接,那么用户线程会调用1万次的系统调用read来进行处理,在用户空间这种开销太大,那么现在须要办理这个问题,思路便是让用户进程减少系统调用,但是用户自己是实现不了的,以是这就导致了内核发生了进一步变革。在内核空间中帮助用户进程遍历所有的文件描述符,将数据准备好的文件描述符返回给用户进程。该办法是同步壅塞IO,由于在第一阶段的IO调用会壅塞进程。

IO多路复用是指内核一旦创造进程指定的一个或者多个IO条件准备读取,它就关照该进程,目前支持I/O多路复用的系统调用有 select 、 poll 、 epoll 。

,I/O多路复用便是通过一种机制,一个进程可以监视多个描述符(socket),一旦某个描述符就绪(一样平常是读就绪或者写就绪),能够关照程序进行相应的读

写操作。

select/poll为了让内核帮助用户进程完成文件描述符的遍历,内核增加了系统调用select/poll(select与poll实质上没有什么不同,便是poll减少了文件描述符的个数限定),现在用户进程只须要调用select系统调用函数,并且将文件描述符全部通报给select就可以让内核帮助用户进程完成所有的查询,然后将数据准备好的文件描述符再返回给用户进程,末了用户进程依次调用其他系统调用函数完成IO的实行过程。

epoll在select实现的多路复用中依然存在一些问题。

1、用户进程须要通报所有的文件描述符,然后内核将数据准备好的文件描述符再次通报回去,这种数据的拷贝降落了IO的速率。2、内核依然会实行繁芜度为O(n)的主动遍历操作。

对付第一个问题,提出了一个共享空间的观点,这个空间为用户进程和内核进程所共享,并且供应了mmap系统调用,实现用户空间和内核空间到共享空间的映射,这样用户进程就可以将1万个文件描述符写到共享空间中的红黑树上,然后内核将准备就绪的文件描述符写入共享空间的链表中,而用户进程创造链表中有数据了就直接读取然后调用read实行IO即可。

对付第二个问题,内核引入了事宜驱动机制(类似于中断),不再主动遍历所有的文件描述符,而是通过事宜驱动的办法主动关照内核该文件描述符的数据准备完毕了,然后内核就将其写入链表中即可。

对付epoll来说在第一阶段的epoll_wait依然是壅塞的,故也是同步壅塞式IO。

模型4:旗子暗记驱动式IO在IO实行的数据准备阶段,不会壅塞用户进程。当用户进程须要等待数据的时候,会向内核发送一个旗子暗记,见告内核须要数据,然后用户进程就连续做别的事情去了,而当内核中的数据准备好之后,内核立马发给用户进程一个旗子暗记,用户进程收到旗子暗记之后,立马调用recvfrom,去查收数据。 该IO模型利用的较少。

模型5:异步IO(AIO)

运用进程通过 aio_read 奉告内核启动某个操作,并且在全体操作完成之后再关照运用进程,包括把数据从内核空间拷贝到用户空间。旗子暗记驱动 IO 是内核关照我们何时可以启动一个 IO 操作,而异步 IO 模型是由内核关照我们 IO 操作何时完成。是真正意义上的无壅塞的IO操作,但是目前只有windows支持AIO,linux内核暂时不支持。

总结

前四种模型的紧张差异于第一阶段,由于他们的第二阶段都是一样的:在数据从内核拷贝到运用进程的缓冲区期间,进程都会壅塞。相反,异步 IO 模型在这两个阶段都不会壅塞,从而不同于其他四种模型。

直接内存与零拷贝

直接内存并不是虚拟机运行时数据区的一部分,也不是Java 虚拟机规范中所定义的内存区域。直接内存申请空间耗费更高的性能,直接内存IO读写的性能要优于普通的堆内存,对付java程序来说,系统内核读取堆类的工具须要根据代码段打算其偏移量来获取工具地址,效率较慢,不太适宜网络IO的场景,对付直接内存来说更加适宜IO操作,内核读取存放在直接内存中的工具较为方便,由于其地址便是袒露的进程虚拟地址,不须要jvm翻译。那么就可以利用mmap开辟一块直接内存mapbuffer和内核空间共享,并且该直接内存可以直接映射到磁盘上的文件,这样就可以通过调用本地的put而不用调用系统调用write就可以将数据直接写入磁盘,RandomAccessFile类便是通过开辟mapbuffer实现的读写磁盘。

以行列步队Kafka来说,有生产者和消费者,对付生产者,从网络发来一个msg并且被拷贝到内核缓冲区,该通过Kafka调用recvfrom将内核中的msg读到行列步队中,然后加上头head,再将该写入磁盘。如果没有mmap的话,就会调用一个write系统调用将该写入内核缓冲区,然后内核将该再写入磁盘。在此过程中涌现一次80中断和2次拷贝。但实际上Kafka利用的是mmap开辟了直接内存到磁盘的映射,直策应用put将写入磁盘。实际上也是通过内核访问该共享区域将该写入的磁盘。同时在Kafka中有一个观点叫segment,一样平常为1G大小。它会充分利用磁盘的顺序性,只追加数据,不修正数据。而mmap会直接开辟1G的直接内存,并且直接与segment形成映射关系,在segment满了的时候再开辟一个新的segment,清空直接内存然后在与新的segment形成映射关系。

零拷贝描述的是CPU不实行拷贝数据从一个存储区域到另一个存储区域的任务,这常日用于通过网络传输一个文件时以减少CPU周期和内存带宽。

在Kafka的消费者读取数据的时候,如果当前消费者想读取的数据是不是当前直接内存所映射的segment怎么办?如果没有零拷贝的话,进程会先去调用read读取,然后数据会从磁盘被拷贝到内核,然后内核再拷贝到Kafka行列步队,进程再调用write将数据拷贝到内核缓冲区,末了再发送给消费者。实际上可以创造,数据没有必要读到Kafka行列步队,直接读到内核的缓冲区的时候发送给消费者就行了。实际上,linux内核中有一个别系调用便是实现了这种办法读取数据——sendfile,它有2个参数,一个是infd(读取数据的文件描述符),一个是outfd(客户真个socket文件描述符).消费者只需调用该函数,见告它须要读取哪个文件就可以不经由Kafka直接将数据读到内核,然后由内核写到消费者进程的缓冲区中。

2 nginx事理理解2.1 什么是nginx

Nginx 是一款自由的、开源的、高性能的HTTP做事器和反向代理做事器;同时也是一个IMAP、POP3、SMTP代理做事器; Nginx 可以作为一个HTTP做事器进行网站的发布处理,其余 Nginx 可以作为反向代理进行负载均衡的实现。

2.1.1 nginx的三个紧张运用处景1、静态资源做事(通过本地文件系统供应做事)

2、缓存、负载均衡做事器

3、API做事(OpenResty)

2.2 为什么选择nginx?更快 这表现在两个方面:一方面,在正常情形下,单次要求会得到更快的相应;另一方面, 在高峰期(如有恒河沙数的并发要求), Nginx 可以比其他Web做事器更快地相应要求。高扩展性 Nginx 的设计极具扩展性,它完备是由多个不同功能、不同层次、不同类型且耦合度极低的模块组成。因此,当对某一个模块修复 Bug 或进行升级时,可以专注于模块自身,无须在意其他。 而且在HTTP模块中,还设计了 HTTP 过滤器模块:一个正常的 HTTP 模块在处理完要求后,会有一串 HTTP 过滤器模块对要求的结果进行再处理。这样,当我们开拓一个新的 HTTP 模块时,不但可以利用诸如 HTTP 核心模块、events模块、log模块 平分歧层次或者不同类型的模块,还可以原封不动地复用大量已有的 HTTP 过滤器模块。 这种低耦合度的精良设计,造就了 Nginx 弘大的第三方模块,当然,公开的第三方模块也如官方发布的模块一样随意马虎利用。 Nginx 的模块都是嵌入到二进制文件中实行的,无论官方发布的模块还是第三方模块都是如此。这使得第三方模块一样具备极其精良的性能,充分利用 Nginx的高并发特性,因此,许多高流量的网站都方向于开拓符合自己业务特性的定制模块。高可靠性 高可靠性是我们选择 Nginx 的最基本条件,由于 Nginx 的可靠性是大家有目共睹的,很多家高流量网站都在核心做事器上大规模利用 Nginx 。 Nginx 的高可靠性来自于其核心框架代码的精良设计、模块设计的大略性;其余,官方供应的常用模块都非常稳定,每个 worker 进程相对独立,master进程在1个worker进程出错时可以快速“拉起”新的 worker 子进程供应做事。低内存花费 一样平常情形下,10000个非生动的HTTP Keep-Alive连接在 Nginx 中仅花费2.5MB的内存,这是 Nginx 支持高并发连接的根本。单机支持10万以上的并发连接 这是一个非常主要的特性!

随着互联网的迅猛发展和互联网用户数量的成倍增长,各大公司、网站都须要搪塞海量并发要求,一个能够在峰值期顶住10万以上并发要求的Server, 无疑会得到大家的青睐。理论上,Nginx支持的并发连接上限取决于内存,当然,能够及时地处理更多的并发要求,是与业务特点紧密干系的。热支配 master管理进程与 worker 事情进程的分离设计,使得 worker 能够供应热支配功能,即可以在7×24小时不间断做事的条件下,升级 worker 的可实行文件。当然,它也支持一直止做事就更新配置项、改换日志文件等功能。最自由的BSD容许协议 这是 worker 可以快速发展的强大动力。BSD容许协议不但是许可用户免费利用 worker ,它还许可用户在自己的项目中直策应用或修正 worker 源码,然后发布。这吸引了无数开拓者连续为 worker 贡献自己的聪慧。2.3 Nginx干系的开源版本

1、阿里巴巴Tengine Tengine是由淘宝网发起的Web做事器项目。它在Nginx的根本上,针对大访问量网站的需求,添加了很多高等功能和特性。

2、openresty OpenResty® 是一个基于 Nginx 与 Lua 的高性能 Web 平台,其内部集成了大量精良的 Lua 库、第三方模块以及大多数的依赖项。用于方便地搭建能够处理超高并发、扩展性极高的动态 Web 运用、Web 做事和动态网关。

2.4 Nginx高效的缘故原由及事理解析2.4.1 做事器的网络做事模型web做事器和客户端是一对多的关系,Web做事器必须有能力同时为多个客户端供应做事。一样平常来说完成并行处理要求事情有三种办法:

2.4.1.1 单进程壅塞的网络做事器解释:

1、创建一个socket,绑定做事器端口(bind),监听端口(listen),在PHP中用stream_socket_server一个函数就能完成上面3个步骤2、进入while循环,壅塞在accept操作上,等待客户端连接进入。此时程序会进入就寝状态,直到有新的客户端发起connect到做事器,操作系统会唤醒此进程。accept函数返回客户端连接的socket3、利用fread读取客户端socket当中的数据收到数据后做事器程序进行处理然后利用fwrite向客户端发送相应。长连接的做事会持续与客户端交互,而短连接做事一样平常收到相应就会close。

缺陷: 一次只能处理一个连接,不支持多个长连接同时处理

2.4.1.2 多进程办法多进程办法指,做事器每当收到一个客户端要求时,就有做事器主进程天生一个子进程出来和客户端建立连接进行交互,直到连接断开该子进程就结束了。

解释:

前面流程同等就不补充了1、程序启动后就会创建N个进程。每个子进程进入 Accept,等待新的连接进入。当客户端连接到做事器时,个中一个子进程会被唤醒,开始处理客户端要求,并且不再接管新的TCP连接。 当连接关闭时,子进程会开释,重新进入 Accept,参与处理新的连接。 这个模型的上风是完备可以复用进程,不须要太多的高下文切换,比如php-fpm基于此模型来处理解析php.

多进程办法的优点是设计大略,各个子进程相对独立,处理客户端要求时彼此不受滋扰;

缺陷是操作系统天生一个子进程须要进行内存复制等操作,在资源和韶光上会产生一定的开销;当有大量要求时,会导致系统性能低落;

例如:即时谈天程序,一台做事器可能要坚持数十万的连接,那么就要启动数十万的进程来坚持。这显然不可能

2.4.1.3 多线程办法多线程办法指每当做事器吸收到一个要求后,会由做事器主进程派生出一个线程出来和客户端进行交互。由于操作系统产生出一个线程的开销远远小于一个进程的开销。故多线程办法在很大程度上减轻了Web做事器对系统资源的哀求。

缺陷:稳定性!

假设某个进程溘然关闭会造玉成部进程中的所有线程都崩溃。

基于上面的模式我们创造单个进程每次只能通过每次(accept)处理单个要求,有没有办法一次性连接多个要求,须要的时候再处理呢?

2.4.1.4 单进程IO复用办法解释:

1、保存所有的socket,通过select模型,监听socket描述符的可读事宜2、Select会在内核空间监听一旦创造socket可读,会从内核空间通报至用户空间,在用户空间通过逻辑判断是做事端socket可读,还是客户真个socket可读3、如果是做事真个socket可读,解释有新的客户端建立,将socket保留到监听数组当中4、如果是客户真个socket可读,解释当前已经可以去读取客户端发送过来的内容了,通过fread读取socket内容,然后fwrite相应给客户端。

缺陷:稳定性!

某个进程或线程出错,可能导致大量要求无法处理,乃至导致全体做事宕机,单进程对付大量任务处理乏力。

1.Nginx启动后,会产生一个主进程,主进程实行一系列的事情后会产生一个或者多个事情进程2.在客户端要求动态站点的过程中,Nginx做事器还涉及和后端做事器的通信。Nginx将吸收到的Web要求通过代理转发到后端做事器,由后端做事器进行数据处理和组织;3.Nginx为了提高对要求的相应效率,降落网络压力,采取了缓存机制,将历史应答数据缓存到本地。保障对缓存文件的快速访问

master进程紧张用来管理 worker 进程,详细包括以下紧张功能:

(1)吸收来自外界的旗子暗记。(2)处理配置文件读取。(3)创建,绑定和关闭套接字(4)启动,终止和掩护配置的事情(worker)进程数(5)当woker进程退出后(非常情形下),会自动重新启动新的woker进程

worker 进程的紧张任务是完成详细的任务逻辑。其紧张关注点是与客户端或后端真实做事器(此时 worker 作为中间代理)之间的数据可读/可写等I/O交互事宜。

(1)吸收客户端要求;(2)将要求一次送入各个功能模块进行过滤处理;(3)与后端做事器通信,吸收后端做事器处理结果;(4)数据缓存;(5)相应客户端要求;

如果以为本文对你有帮助,可以转发关注支持一下