作者:Jean de Dieu Nyandwi

机器之心编译

机器之心编辑部

这篇文章从感知机开始,按照韶光顺序回顾了深度学习的历史。

1958 年:感知机的兴起

1958 年,弗兰克 · 罗森布拉特发明了感知机,这是一种非常大略的机器模型,后来成为当今智能机器的核心和起源。

感知机是一个非常大略的二元分类器,可以确定给定的输入图像是否属于给定的类。为了实现这一点,它利用了单位阶跃激活函数。利用单位阶跃激活函数,如果输入大于 0,则输出为 1,否则为 0。

下图是感知机的算法。

感知机

Frank 的意图不是将感知机构建为算法,而是构建成一种机器。感知机是在名为 Mark I 感知机的硬件中实现的。Mark I 感知机是一台纯电动机器。它有 400 个光电管(或光电探测器),其权重被编码到电位器中,权重更新(发生在反向传播中)由电动机实行。下图是 Mark I 感知机。

Mark I 感知机。图片来自美国国家历史博物馆

就像你本日在新闻中看到的关于神经网络的内容一样,感知机也是当时的头条新闻。《纽约时报》宣布说,“[海军] 期望电子打算机的初步模型能够行走、说话、不雅观察、书写、自我复制并意识到它的存在”。本日,我们都知道机器仍旧难以行走、说话、不雅观察、书写、复制自己,而意识则是另一回事。

Mark I 感知机的目标仅仅是识别图像,而当时它只能识别两个种别。人们花了一些韶光才知道添加更多层(感知机是单层神经网络)可以使网络具有学习繁芜功能的能力。这进一步产生了多层感知机 (MLP)。

1982~1986 : 循环神经网络 (RNN)

在多层感知机显示出办理图像识别问题的潜力之后,人们开始思考如何对文本等序列数据进行建模。

循环神经网络是一类旨在处理序列的神经网络。与多层感知机 (MLP) 等前馈网络不同,RNN 有一个内部反馈回路,卖力记住每个韶光步的信息状态。

前馈网络与循环神经网络

第一种 RNN 单元在 1982 年到 1986 年之间被创造,但它并没有引起人们的把稳,由于大略的 RNN 单元在用于长序列时会受到很大影响,紧张是由于影象力短和梯度不稳定的问题。

1998:LeNet-5:第一个卷积神经网络架构

LeNet-5 是最早的卷积网络架构之一,于 1998 年用于文档识别。LeNet-5 由 3 个部分组成:2 个卷积层、2 个子采样或池化层和 3 个全连接层。卷积层中没有激活函数。

正如论文所说,LeNet-5 已进行商业化支配,每天读取数百万张支票。下面是 LeNet-5 的架构。该图像取自其原始论文。

LeNet-5 在当时确实是一个有影响力的东西,但它(常规的卷积网络)直到 20 年后才受到关注!

LeNet-5 建立在早期事情的根本上,例如福岛邦彦提出的第一个卷积神经网络、反向传播(Hinton 等人,1986 年)和运用于手写邮政编码识别的反向传播(LeCun 等人,1989 年)。

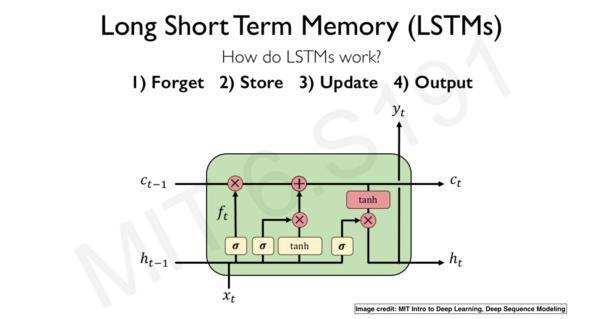

1998:是非期影象(LSTM)

由于梯度不稳定的问题,大略 RNN 单元无法处理长序列问题。LSTM 是可用于处理长序列的 RNN 版本。LSTM 基本上是 RNN 单元的极度情形。

LSTM 单元的一个分外设计差异是它有一个门机制,这是它可以掌握多个韶光步长的信息流的根本。

简而言之,LSTM 利用门来掌握从当前韶光步到下一个韶光步的信息流,有以下 4 种办法:

输入门识别输入序列。遗忘门去掉输入序列中包含的所有不干系信息,并将干系信息存储在长期影象中。LTSM 单元更新更新单元的状态值。输出门掌握必须发送到下一个韶光步的信息。LSTM 架构。图片取自 MIT 的课程《6.S191 Introduction to Deep Learning》

LSTM 处理长序列的能力使其成为适宜各种序列任务的神经网络架构,例如文本分类、情绪剖析、语音识别、图像标题天生和机器翻译。

LSTM 是一种强大的架构,但它的打算本钱很高。2014 年推出的 GRU(Gated Recurrent Unit)可以办理这个问题。与 LSTM 比较,它的参数更少,而且效果也很好。

2012 年:ImageNet 寻衅赛、AlexNet 和 ConvNet 的兴起

如果跳过 ImageNet 大规模视觉识别寻衅赛 (ILSVRC) 和 AlexNet,就险些不可能谈论神经网络和深度学习的历史。

ImageNet 寻衅赛的唯一目标是评估大型数据集上的图像分类和工具分类架构。它带来了许多新的、强大的、有趣的视觉架构,我们将简要回顾这些架构。

寻衅赛始于 2010 年,但在 2012 年发生了变革,AlexNet 以 15.3% 的 Top 5 低缺点率赢得了寻衅,这险些是之前得胜者缺点率的一半。AlexNet 由 5 个卷积层、随后的最大池化层、3 个全连接层和一个 softmax 层组成。AlexNet 提出了深度卷积神经网络可以很好地处理视觉识别任务的想法。但当时,这个不雅观点还没有深入到其他运用上!

在随后的几年里,ConvNets 架构不断变得更大并且事情得更好。例如,有 19 层的 VGG 以 7.3% 的缺点率赢得了寻衅。GoogLeNet(Inception-v1) 更进一步,将缺点率降落到 6.7%。2015 年,ResNet(Deep Residual Networks)扩展了这一点,并将缺点率降落到 3.6%,并表明通过残差连接,我们可以演习更深的网络(超过 100 层),在此之前,演习如此深的网络是不可能的。之古人们创造更深层次的网络事情得更好,这导致了其他新架构,如 ResNeXt、Inception-ResNet、DenseNet、Xception 等。

读者可以在这里找到这些架构和其他当代架构的总结和实现:https://github.com/Nyandwi/ModernConvNets

ModernConvNets 库。

ImageNet 寻衅赛。图片来自课程《 CS231n》

2014 年 : 深度天生网络

天生网络用于从演习数据中天生或合成新的数据样本,例如图像和音乐。

天生网络有很多种类型,但最盛行的类型是由 Ian Goodfellow 在 2014 年创建的天生对抗网络 (GAN)。GAN 由两个紧张组件组成:天生假样本的天生器和区分真实样本和天生器天生样本的判别器。天生器和鉴别器可以说是相互竞争的关系。他们都是独立演习的,在演习过程中,他们玩的是零和游戏。天生器不断天生欺骗判别器的假样本,而判别器则努力创造那些假样本(参考真实样本)。在每次演习迭代中,天生器在天生靠近真实的假样本方面做得更好,判别器必须提高标准来区分不真实的样本和真实样本。

GAN 一贯是深度学习社区中最热门的事物之一,该社区以天生假造的图像和 Deepfake 视频而有名。如果读者对 GAN 的最新进展感兴趣,可以阅读 StyleGAN2、DualStyleGAN、ArcaneGAN 和 AnimeGANv2 的简介。如需 GAN 资源的完全列表,请查看 Awesome GAN 库:https://github.com/nashory/gans-awesome-applications。下图解释了 GAN 的模型架构。

天生对抗网络(GAN)

GAN 是天生模型的一种。其他盛行的天生模型类型还有 Variation Autoencoder (变分自编码器,VAE)、AutoEncoder (自编码器)和扩散模型等。

2017 年:Transformers 和把稳力机制

韶光来到 2017 年。ImageNet 寻衅赛结束了。新的卷积网络架构也被制作出来。打算机视觉社区的每个人都对当前的进展感到高兴。核心打算机视觉任务(图像分类、目标检测、图像分割)不再像以前那样繁芜。人们可以利用 GAN 天生逼真的图像。NLP 彷佛掉队了。但是随后涌现了一些事情,并且在全体网络上都成为了头条新闻:一种完备基于把稳力机制的新神经网络架构横空出世。并且 NLP 再次受到启示,在随后的几年,把稳力机制连续主导其他方向(最显著的是视觉)。该架构被称为 Transformer 。

在此之后的 5 年,也便是现在,我们在这里评论辩论一下这个最大的创新成果。Transformer 是一类纯粹基于把稳力机制的神经网络算法。Transformer 不该用循环网络或卷积。它由多头把稳力、残差连接、层归一化、全连接层和位置编码组成,用于保留数据中的序列顺序。下图解释了 Transformer 架构。

图片来自于《Attention Is All You Need》

Transformer 彻底改变了 NLP,目前它也在改变着打算机视觉领域。在 NLP 中,它被用于机器翻译、文本择要、语音识别、文本补全、文档搜索等。

读者可以在其论文 《Attention is All You Need》 中理解有关 Transformer 的更多信息。

2018 年至今

自 2017 年以来,深度学习算法、运用和技能突飞年夜进。为了清楚起见,后来的先容是按种别划分的。在每个种别中,我们都会重新核阅紧张趋势和一些最主要的打破。

Vision Transformers

Transformer 在 NLP 中表现出精良的性能后不久,一些勇于创新的人就迫不及待地将把稳力机制放到了图像上。在论文《An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale》中,谷歌的几位研究职员表明,对直接在图像块序列上运行的正常 Transformer 进行轻微修正可以在图像分类数据集上产生本色性的结果。他们将他们的架构称为 Vision Transformer (ViT),它在大多数打算机视觉基准测试中都有表示(在作者撰写本文时,ViT 是 Cifar-10 上最前辈的分类模型)。

ViT 设计师并不是第一个考试测验在识别任务中利用把稳力机制的人。我们可以在论文 Attention Augmented Convolutional Networks 中找到第一个利用的记录,这篇论文试图结合自把稳力机制和卷积(摆脱卷积紧张是由于 CNN 引入的空间归纳偏置)。另一个例子见于论文《Visual Transformers: Token-based Image Representation and Processing for Computer Vision,这篇论文在基于滤波器的 token 或视觉 token 上运行 Transformer。这两篇论文和许多其他未在此处列出的论文打破了一些基线架构(紧张是 ResNet)的界线,但当时并没有超越当前的基准。ViT 确实是最伟大的论文之一。这篇论文最主要的见地之一是 ViT 设计师实际上利用图像 patch 作为输入表示。他们对 Transformer 架构没有太大的改变。

Vision Transformer(ViT)

除了利用图像 patch 之外,使 Vision Transformer 成为强大架构的构造是 Transformer 的超强并行性及其缩放行为。但就像生活中的统统一样,没有什么是完美的。一开始,ViT 在视觉下贱任务(目标检测和分割)上表现不佳。

在引入 Swin Transformers 之后,Vision Transformer 开始被用作目标检测和图像分割等视觉下贱任务的骨干网络。Swin Transformer 超强性能的核心亮点是由于在连续的自把稳力层之间利用了移位窗口。下图描述了 Swin Transformer 和 Vision Transformer (ViT) 在构建分层特色图方面的差异。

图片来自 Swin Transformer 原文

Vision Transformer 一贯是比来最令人愉快的研究领域之一。我们可以在这里谈论许多 Vision Transformers 论文,但读者可以在论文《Transformers in Vision: A Survey》中理解更多信息。其他最新视觉 Transformer 还有 CrossViT、ConViT 和 SepViT 等。

视觉和措辞模型

视觉和措辞模型常日被称为多模态。它们是涉及视觉和措辞的模型,例如文本到图像天生(给定文本,天生与文本描述匹配的图像)、图像字幕(给定图像,天生其描述)和视觉问答(给定一个图像和关于图像中内容的问题,天生答案)。Transformer 在视觉和措辞领域的成功很大程度上匆匆成了多模型作为一个单一的统一网络。

实际上,所有视觉和措辞任务都利用了预演习技能。在打算机视觉中,预演习须要对在大型数据集(常日是 ImageNet)上演习的网络进行微调,而在 NLP 中,每每是对预演习的 BERT 进行微调。要理解有关 V-L 任务中预演习的更多信息,请阅读论文《A Survey of Vision-Language Pre-Trained Models》。有关视觉和措辞任务、数据集的一样平常概述,请查看论文《Trends in Integration of Vision and Language Research: A Survey of Tasks, Datasets, and Methods》。

前段韶光,OpenAI 发布了 DALL·E 2(改进后的 DALL·E),这是一种可以根据文本天生逼真图像的视觉措辞模型。现有的文本转图像模型有很多,但 DALL·E 2 的分辨率、图像标题匹配和真实感都相称出色。

DALL·E 2 尚未对"大众年夜众开放,但你可以加入候补名单。以下是 DALL·E 2 创建的一些图像示例。

上面呈现的 DALL·E 2 天生的图像取自一些 OpenAI 员工,例如 @sama、@ilyasut、@model_mechanic 和 openaidalle。

大规模措辞模型 (LLM)

措辞模型有多种用场。它们可用于预测句子中的下一个单词或字符、总结一段文档、将给定文本从一种措辞翻译成另一种措辞、识别语音或将一段文本转换为语音。

开玩笑地说,发明 Transformers 的人必须为措辞模型在朝着大规模参数化方向提高受到责怪(但实际上没有人该当受到责备,Transformers 是 2010 年代十年中最伟大的发明之一,大模型令人震荡的地方在于:如果给定足够的数据和打算,它总能更好地事情)。在过去的 5 年中,措辞模型的大小一贯在不断增长。

在引入论文《Attention is all you need》一年后,大规模措辞模型开始涌现。2018 年,OpenAI 发布了 GPT(Generative Pre-trained Transformer),这是当时最大的措辞模型之一。一年后,OpenAI 发布了 GPT-2,一个拥有 15 亿个参数的模型。又一年后,他们发布了 GPT-3,它有 1750 亿个参数。GPT-3 用了 570GB 的 文本来演习。这个模型有 175B 的参数,模型有 700GB 大。根据 lambdalabs 的说法,如果利用在市场上价格最低的 GPU 云,演习它须要 366 年,花费 460 万美元!

GPT-n 系列型号仅仅是个开始。还有其他更大的模型靠近乃至比 GPT-3 更大。如:NVIDIA Megatron-LM 有 8.3B 参数。最新的 DeepMind Gopher 有 280B 参数。2022 年 4 月 12 日,DeepMind 发布了另一个名为 Chinchilla 的 70B 措辞模型,只管比 Gopher、GPT-3 和 Megatron-Turing NLG(530B 参数)小,但它的性能优于许多措辞模型。Chinchilla 的论文表明,现有的措辞模型是演习不敷的,详细来说,它表明通过将模型的大小更加,数据也该当更加。但是,险些在同一周内又涌现了具有 5400 亿个参数的 Google Pathways 措辞模型(PaLM)!

Chinchilla 措辞模型

代码天生模型

代码天生是一项涉及补全给定代码或根据自然措辞或文本天生代码的任务,或者大略地说,它是可以编写打算机程序的人工智能系统。可以猜到,当代代码天生器是基于 Transformer 的。

我们可以确定地说,人们已经开始考虑让打算机编写自己的程序了(就像我们梦想教打算机做的所有其他事情一样),但代码天生器在 OpenAI 发布 Codex 后受到关注。Codex 是在 GitHub 公共仓库和其他公共源代码上微调的 GPT-3。OpenAI 表示:“OpenAI Codex 是一种通用编程模型,这意味着它基本上可以运用于任何编程任务(只管结果可能会有所不同)。我们已经成功地将它用于编译、阐明代码和重构代码。但我们知道,我们只触及了可以做的事情的皮毛。” 目前,由 Codex 支持的 GitHub Copilot 扮演着结对程序员的角色。

在我利用 Copilot 后,我对它的功能感到非常惊异。作为不编写 Java 程序的人,我用它来准备我的移动运用程序(利用 Java)考试。人工智能帮助我准备学术考试真是太酷了!

在 OpenAI 发布 Codex 几个月后,DeepMind 发布了 AlphaCode,这是一种基于 Transformer 的措辞模型,可以办理编程竞赛问题。AlphaCode 发布的博文称:“AlphaCode 通过办理须要结合批驳性思维、逻辑、算法、编码和自然措辞理解的新问题,在编程竞赛的参与者中估计排名前 54%。” 办理编程问题(或一样平常的竞争性编程)非常困难(每个做过技能口试的人都赞许这一点),正如 Dzmitry 所说,击败 “人类水平仍旧遥遥无期”。

前不久,来自 Meta AI 的科学家发布了 InCoder,这是一种可以天生和编辑程序的天生模型。

更多关于代码天生的论文和模型可以在这里找到:https://paperswithcode.com/task/code-generation/codeless

再次回到感知机

在卷积神经网络和 Transformer 兴起之前的很长一段韶光里,深度学习都环绕着感知机展开。ConvNets 在取代 MLP 的各种识别任务中表现出精良的性能。视觉 Transformer 目前也展示出彷佛是一个很有出息的架构。但是感知机完备去世了吗?答案可能不是。

在 2021 年 7 月,两篇基于感知机的论文被揭橥。一个是 MLP-Mixer: An all-MLP Architecture for Vision,另一个是 Pay Attention to MLPs(gMLP) .

MLP-Mixer 声称卷积和把稳力都不是必需的。这篇论文仅利用多层感知机 (MLP),就在图像分类数据集上取得了很高的准确性。MLP-Mixer 的一个主要亮点是它包含两个紧张的 MLP 层:一个独立运用于图像块(通道稠浊),另一个层跨块运用(空间稠浊)。

gMLP 还表明,通过避免利用自把稳和卷积(当前 NLP 和 CV 的实际利用的办法),可以在不同的图像识别和 NLP 任务中实现很高的准确性。

读者显然不会利用 MLP 去得到最前辈的性能,但它们与最前辈的深度网络的可比性却是令人着迷的。

再次利用卷积网络:2020 年代的卷积网络

自 Vision Transformer(2020 年)推出以来,打算机视觉的研究环绕着 Transformer 展开(在 NLP 中,transformer 已经是一种规范)。Vision Transformer (ViT) 在图像分类方面取得了最前辈的结果,但在视觉下贱任务(工具检测和分割)中效果不佳。随着 Swin Transformers 的推出, Vision Transformer 很快也接管了视觉下贱任务。

很多人(包括我自己)都喜好卷积神经网络。卷积神经网络确实能起效,而且放弃已经被证明有效的东西是很难的。这种对深度网络模型构造的热爱让一些精彩的科学家回到过去,研究如何使卷积神经网络(准确地说是 ResNet)当代化,使其具有和 Vision Transformer 同样的吸引人的特色。特殊是,他们磋商了「Transformers 中的设计决策如何影响卷积神经网络的性能?」这个问题。他们想把那些塑造了 Transformer 的窍门运用到 ResNet 上。

Meta AI 的 Saining Xie 和他的同事们采取了他们在论文中明确陈述的路线图,终极形成了一个名为 ConvNeXt 的 ConvNet 架构。ConvNeXt 在不同的基准测试中取得了可与 Swin Transformer 相媲美的结果。读者可以通过 ModernConvNets 库(当代 CNN 架构的总结和实现)理解更多关于他们采取的路线图。

结论

深度学习是一个非常有活力、非常宽广的领域。很难概括个中所发生的统统,作者只触及了表面,论文多到一个人读不完。很难跟踪所有内容。例如,我们没有谈论强化学习和深度学习算法,如 AlphaGo、蛋白质折叠 AlphaFold(这是最大的科学打破之一)、深度学习框架的演化(如 TensorFlow 和 PyTorch),以及深度学习硬件。或许,还有其他主要的事情构成了我们没有谈论过的深度学习历史、算法和运用程序的很大一部分。

作为一个小小的免责声明,读者可能已经把稳到,作者倾向于打算机视觉的深度学习。可能还有其他专门为 NLP 设计的主要深度学习技能作者没有涉及。

此外,很难确切地知道某项特定技能是什么时候揭橥的,或者是谁最先揭橥的,由于大多数奇特的东西每每受到以前作品的启示。如有疏忽,读者可以去原文评论区与作者谈论。

原文链接:https://www.getrevue.co/profile/deeprevision/issues/a-revised-history-of-deep-learning-issue-1-1145664