大家好,本日为大家分享一个强大的 Python 库 - joblib。

Github地址:https://github.com/joblib/joblib

在数据科学和机器学习的实践中,效率和性能至关主要。Python的joblib库供应了一个大略的办理方案,用于对重复打算进行缓存,以及高效地保存和加载大型数据,特殊适用于有大量重复打算且打算本钱高昂的任务。这篇文章将详细先容joblib库的安装、特性、根本及高等功能,并通过实际运用处景展示其实用性。

joblib库可以通过pip安装,这是最直接的方法:

pip install joblib

这条命令将从Python包索引(PyPI)下载并安装joblib库。

特性内存缓存:自动缓存函数的输出结果,避免重复打算。高效存储:特殊优化用于存储大型数组,利用joblib进行数据序列化和反序列化比Python标准的pickle更快。并行打算支持:简化了并行打算的实现,能够轻松地在Python代码中实现多核处理。基本功能缓存函数结果

joblib供应了一个装饰器,可以用来缓存函数的打算结果,减少重复打算的韶光。

import timefrom joblib import Memorymemory = Memory("cachedir", verbose=0)def calculate_time(func): def wrapper(args, kwargs): start_time = time.time() result = func(args, kwargs) end_time = time.time() print(f"Function {func.__name__} took {end_time - start_time} seconds to execute.") return result return wrapper@calculate_time@memory.cachedef expensive_computation(a, b): print("Computing...") return a b 123456789# 第一次调用,司帐算并缓存结果res = expensive_computation(12345, 67890)print(res)# 第二次调用,会直接从缓存读取结果res = expensive_computation(12345, 67890)print(res)

输出结果:

Function expensive_computation took 0.0008060932159423828 seconds to execute.103469387947317450Function expensive_computation took 0.0004138946533203125 seconds to execute.103469387947317450

数据序列化和加载

joblib也用于高效序列化大型数据集,特殊是NumPy数组。

import numpy as npfrom joblib import dump, loadarray = np.random.randn(1000, 1000)# 保存数组dump(array, 'large_array.joblib')# 加载数组loaded_array = load('large_array.joblib')print(loaded_array)

输出结果:

[[ 1.30720949 -0.83504804 -0.30874679 ... 1.48698567 -1.42550399 1.46852214] [-0.81095698 -0.28766114 0.86455784 ... 0.03810318 0.58257184 -0.75271085] [ 2.26290674 0.21775626 -0.48887431 ... -0.58892773 -0.3532633 0.86257081] ... [-1.0062814 -0.81872688 -0.38259058 ... 0.03229309 0.28657943 0.28537067] [ 0.52582615 -0.41814374 0.07898395 ... 0.47494961 0.06346098 0.71672982] [-0.04310954 1.09462349 -2.48725894 ... -0.28958333 1.59795983 -0.48119107]]高等功能

多核并行处理

joblib的Parallel和delayed工具使得在多核处理器上实行并行打算变得大略。这对付须要实行大量独立且重复的数据处理任务,如参数搜索和交叉验证在机器学习中的运用,特殊有用。

from joblib import Parallel, delayedimport math# 定义一个打算函数def compute_log(x): return math.log(x)# 并行打算列表中每个元素的对数results = Parallel(n_jobs=4)(delayed(compute_log)(i) for i in range(1, 10))print(results)

在这个示例中,compute_log函数被并行调用,n_jobs=4表示同时利用四个核。

输出结果:

[0.0, 0.6931471805599453, 1.0986122886681098, 1.3862943611198906, 1.6094379124341003, 1.791759469228055, 1.9459101490553132, 2.0794415416798357, 2.1972245773362196]

自定义并行后端

joblib许可选择或自定义并行打算的后端。

例如,可以利用loky(默认)、threading或multiprocessing作为后端来掌握任务的实行办法。

from joblib import Parallel, delayed, parallel_backenddef square(x): return x x# 利用threading后端with parallel_backend('threading', n_jobs=2): results_threading = Parallel(n_jobs=2)(delayed(square)(i) for i in range(10))# 利用multiprocessing后端with parallel_backend('multiprocessing', n_jobs=2): results_multiprocessing = Parallel(n_jobs=2)(delayed(square)(i) for i in range(10))print("Threading results:", results_threading)print("Multiprocessing results:", results_multiprocessing)

在这个示例中,相同的打算任务在不同的后端上实行,展示了如何根据详细任务选择最适宜的并行处理办法。

输出结果:

Threading results: [0, 1, 4, 9, 16, 25, 36, 49, 64, 81]Multiprocessing results: [0, 1, 4, 9, 16, 25, 36, 49, 64, 81]

磁盘缓存的优化

joblib还供应了高等的磁盘缓存机制,这在处理大型数据集时非常有用。通过缓存函数的输出,可以避免重复的打算开销。

from joblib import Memorycache_dir = "joblib_cache"memory = Memory(cache_dir, verbose=0)@memory.cachedef slow_function(x): print("Running slow_function...") return x x x# 第一次调用函数,结果会被缓存result1 = slow_function(2)# 第二次调用相同参数的函数,将直接从缓存中获取结果result2 = slow_function(2)print("Results:", result1, result2)

这个示例展示了如何利用joblib的缓存装饰器来缓存耗时函数的结果,减少重复打算的须要。

Running slow_function...Results: 8 8实际运用处景

大数据集的处理

在处理大型数据集时,常常须要重复实行耗时的数据预处理步骤。利用joblib的缓存功能,可以显著减少重复打算的韶光。

import timefrom joblib import Memoryimport numpy as npcache_dir = "joblib_cache"memory = Memory(cache_dir, verbose=0)def calculate_time(func): def wrapper(args, kwargs): start_time = time.time() result = func(args, kwargs) end_time = time.time() print(f"Function {func.__name__} took {end_time - start_time} seconds to execute.") return result return wrapper@calculate_time@memory.cachedef preprocess_data(data): print("Preprocessing data...") # 假设这是一个繁芜的数据预处理步骤 return np.sqrt(data 2)# 大型数据集large_data = np.random.rand(1000000)# 第一次实行,将会进行打算并缓存结果processed_data = preprocess_data(large_data)print(processed_data)# 第二次实行,将直接从缓存读取结果processed_data = preprocess_data(large_data)print(processed_data)

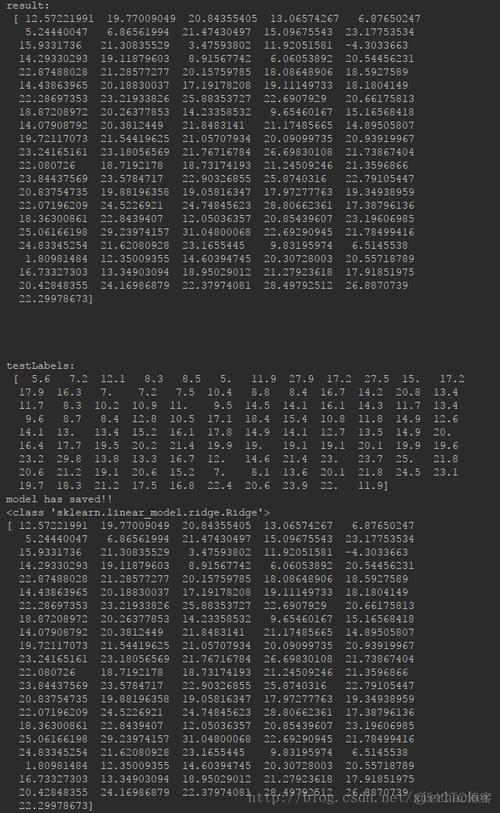

输出结果:

Preprocessing data...Function preprocess_data took 0.06451201438903809 seconds to execute.[0.00428545 0.39904466 0.11454046 ... 0.9410982 0.50532271 0.25387208]Function preprocess_data took 0.015980005264282227 seconds to execute.[0.00428545 0.39904466 0.11454046 ... 0.9410982 0.50532271 0.25387208]

机器学习模型的演习和参数搜索

在机器学习中进行模型演习和参数搜索时,可以利用joblib的并行处理功能来加速这一过程。

from sklearn.datasets import load_irisfrom sklearn.svm import SVCfrom sklearn.model_selection import ParameterGridfrom joblib import Parallel, delayeddata = load_iris()X, y = data.data, data.target# 参数网格param_grid = {'C': [1, 10, 100], 'kernel': ['linear', 'rbf']}def train_model(params): model = SVC(params) model.fit(X, y) return model.score(X, y)# 利用joblib并行处理不同的参数组合results = Parallel(n_jobs=-1)(delayed(train_model)(params) for params in ParameterGrid(param_grid))print("Model scores:", results)

输出结果:

Model scores: [0.9933333333333333, 0.9733333333333334, 0.98, 0.9866666666666667, 0.98, 0.9866666666666667]

自动化脚本和定期任务

joblib可以用于自动化脚本中,尤其是那些涉及重复数据处理任务的脚本。

from joblib import Memoryimport timememory = Memory("cachedir", verbose=0)def calculate_time(func): def wrapper(args, kwargs): start_time = time.time() result = func(args, kwargs) end_time = time.time() print(f"Function {func.__name__} took {end_time - start_time} seconds to execute.") return result return wrapper@calculate_time@memory.cachedef fetch_and_process_data(): print("Fetching and processing data...") # 仿照数据抓取和处理 time.sleep(2) # 仿照耗时操作 return "Data processed"# 假设这个任务须要每天实行for day in range(3): res = fetch_and_process_data() print(f"Day {day + 1}: {res}")

输出结果:

Fetching and processing data...Function fetch_and_process_data took 2.0143320560455322 seconds to execute.Day 1: Data processedFunction fetch_and_process_data took 0.0006558895111083984 seconds to execute.Day 2: Data processedFunction fetch_and_process_data took 0.0005829334259033203 seconds to execute.Day 3: Data processed总结

在本文中,详尽地磋商了Python的joblib库,这是一个专为重复打算优化而设计的库,特殊适宜于数据密集型任务。joblib通过其高效的内存缓存和并行打算功能,极大地提高了数据处理和剖析的速率,从而在机器学习、数据预处理及自动化任务中展现出巨大的上风。我们先容了joblib的安装方法、紧张特性以及基本和高等功能,并通过一系列示例代码展示了这些功能的实际运用。无论是进行大规模数据集的处理,还是加速机器学习模型的演习和参数搜索,joblib都证明了其在提升效率和性能方面的显著能力。